引言

在Event Camera领域基于Contrast Maximization(CMax,或CM)框架衍生了大量的工作,包括光流估计、深度估计、运动估计(2D、3D甚至6D)等等。

其实本质上,CM这个框架是通过对事件进行运动补偿,而在做运动补偿的过程中估算出事件的位移,而这个位移也就是所谓的event point trajectories,而基于像素的位移就可以推广到系列视觉的任务。

CMax aligns point trajectories on the image plane with event data by maximizing the contrast of an image of warped events (IWE)

本博文对Event-based Contrast Maximization进行较为全面的survey,并且将对应的经典论文都做简单的介绍,同时也列出了CMax相关或者用到CMax的文献以作mark

- Keep update the paper list in: Awesome-Event-based-Contrast-Maximization

基本原理

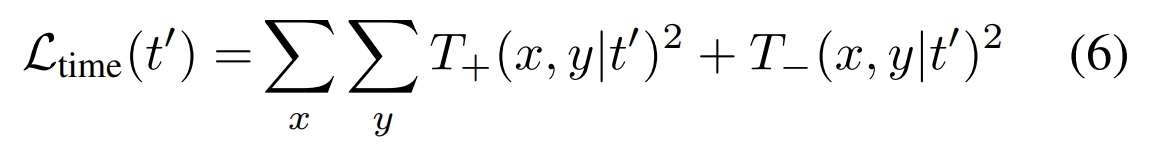

Event-based vision的工作分类有很多种,而其中,按照处理事件的形式可以分为event-by-event和groups of events。而CMax则是属于第二种。

CMax 首次在文献《A Unifying Contrast Maximization Framework for Event Cameras, with Applications to Motion, Depth and Optical Flow Estimation (CVPR2018)》中提出:The main idea of our framework is to find the point trajectories on the image plane that are best aligned with the event data by maximizing an objective function: the contrast of an image of warped events

而其中的寻找point trajectories可以看成是一种隐式的data association,也是Event-based vision种的关键部分,比如short characteristic time (optical flow)或longer estimation time (monocular depth estimation);

此外,CM可以生成motion-corrected event images,既可以看成是对groups of events的运动补偿,也可以看成是由事件产生的图像的梯度或edge image。

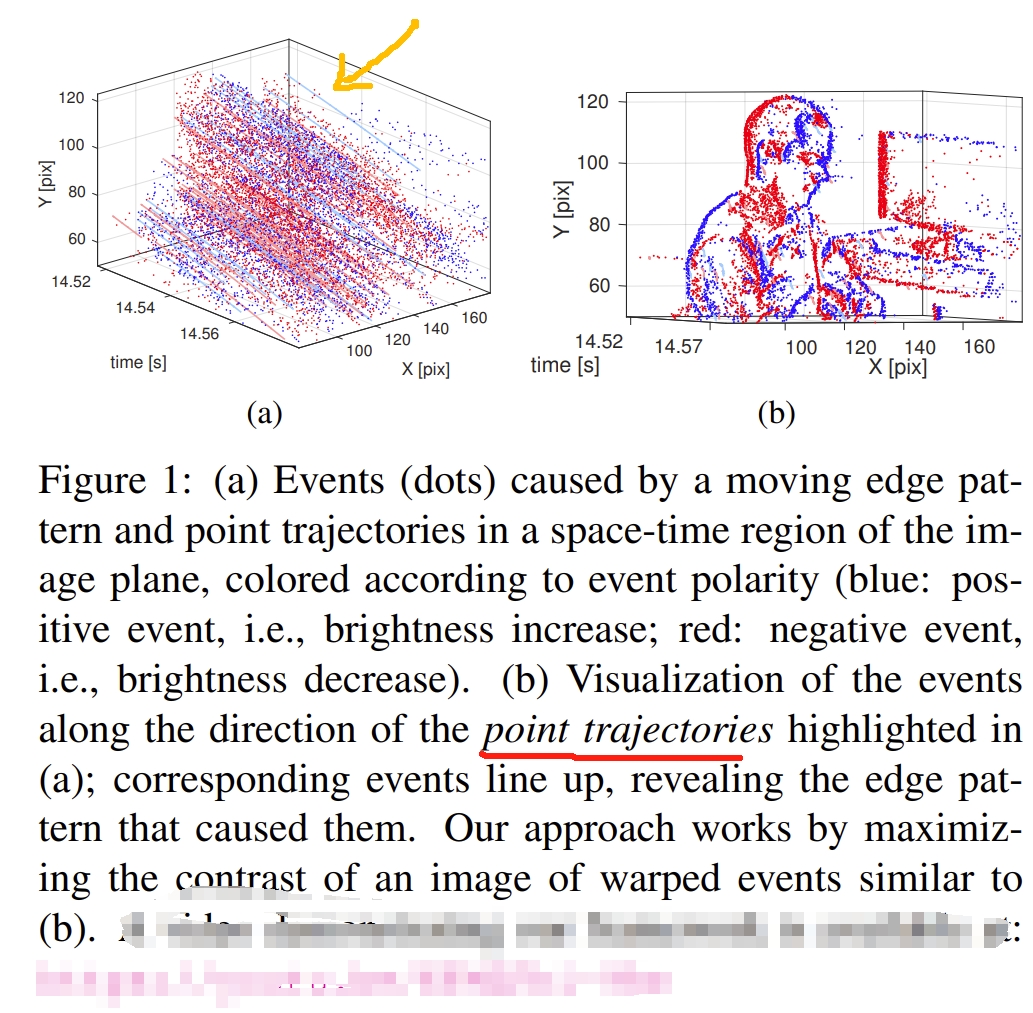

下图较好解析了CM的基本原理,其实就是寻找 point的轨迹,使其较好的与event相align:

|

|

事件相机是motion-active的,一般是由亮度变化或相对运动(相机与场景)产生事件的,并且大部分的事件都是由相对运动的edge来产生的,因此事件相机中的数据关联应该是establishing which events were triggered by the same scene edge。

而移动的edge实际上是描述了在平面上的point trajectory,因此将沿着point trajectory生成的event关联起来也就是数据关联的过程。

如上面右图所示,point trajectory近似于直线。

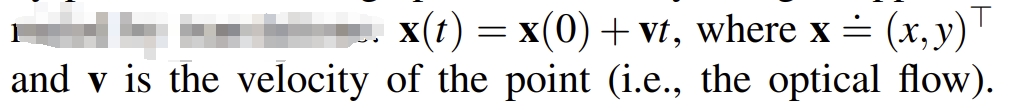

CM算法的框架如上图所示,由以下三步组成:

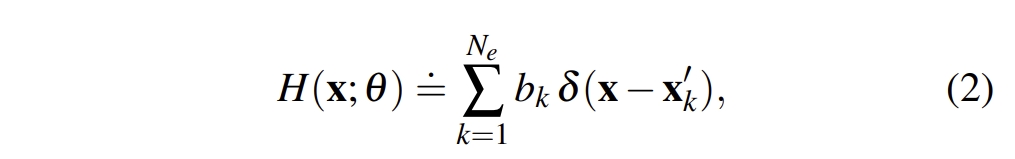

- Warp the events into an image H, according to the point trajectories defined by the geometric model and candidate parameters θ. 所谓的geometric model就是基于optical flow, depth estimation, motion estimation等问题,来描述how points move on the image plane(也就是怎么对event point进行投影)

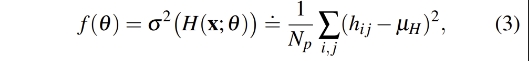

- Compute a score f based on the image of warped events(也就是score function,也就是累积IWE,然后计算对比的score function)

- Optimize the score or objective function with respect to the parameters θ of the model.这步其实就是优化的过程了,比如采用梯度下降或Newton方法来估算最好的θ值。而这个θ其实就是所求的point trajectory了,因为

x=x+θ*t

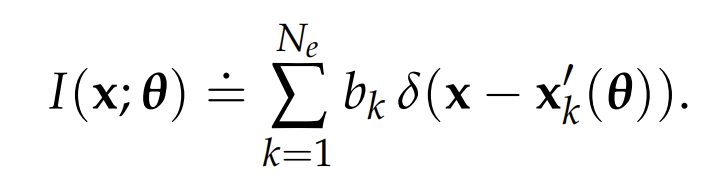

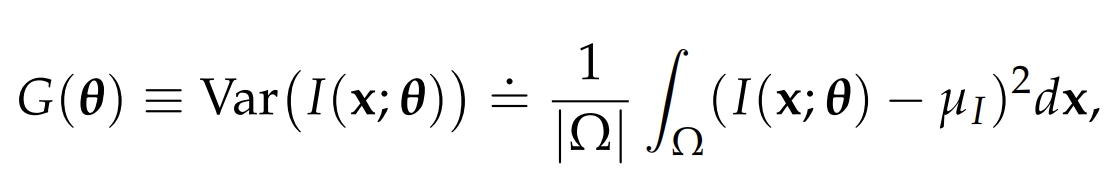

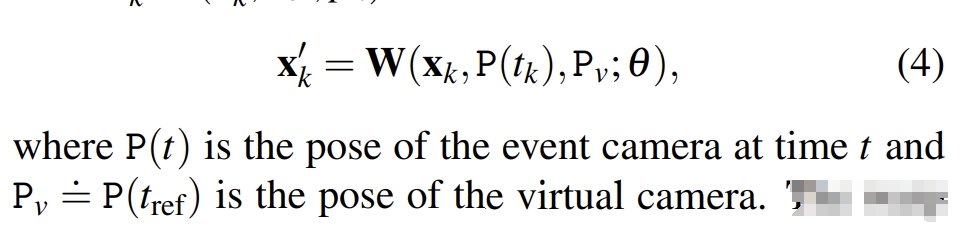

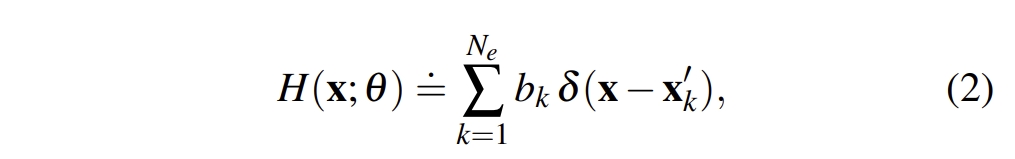

数学描述如下:

|

|

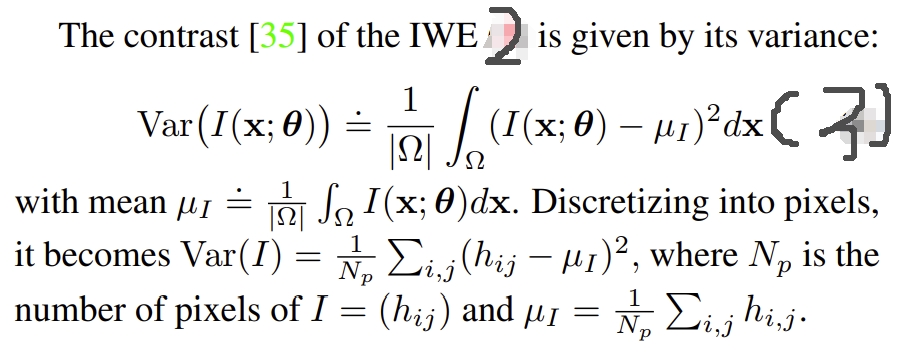

|

对于CM算法,其有两个副产品:

- 估算出point trajectory,隐式建立事件之间的数据关联

- 估算出的point trajectory可以用来对运动的edge做校正(correct)

而此工作作为CM算法的基础工作也给出了CM三大基本应用:Rotational motion estimation(还有motion estimation in planar scenes), Depth estimation, 和 Optical Flow estimation

计算复杂度

而CM算法的时间复杂度应该是O(n),也就是跟事件量成线性关系。其中warp event应该是耗时最大的,想求对比度这些操作几乎可以忽略。此外,优化方法也是影响的重要因素。

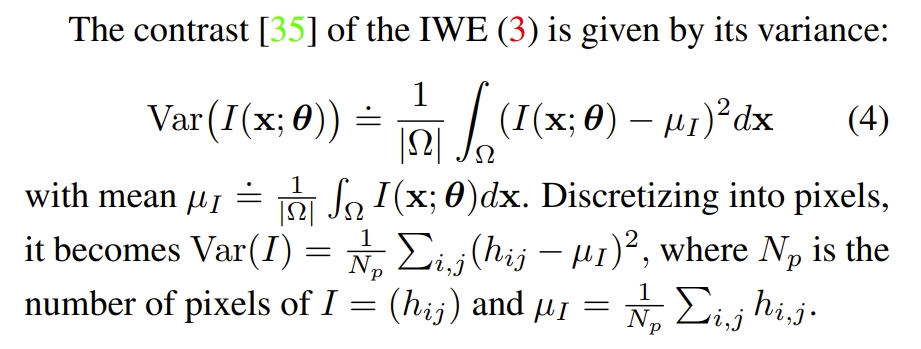

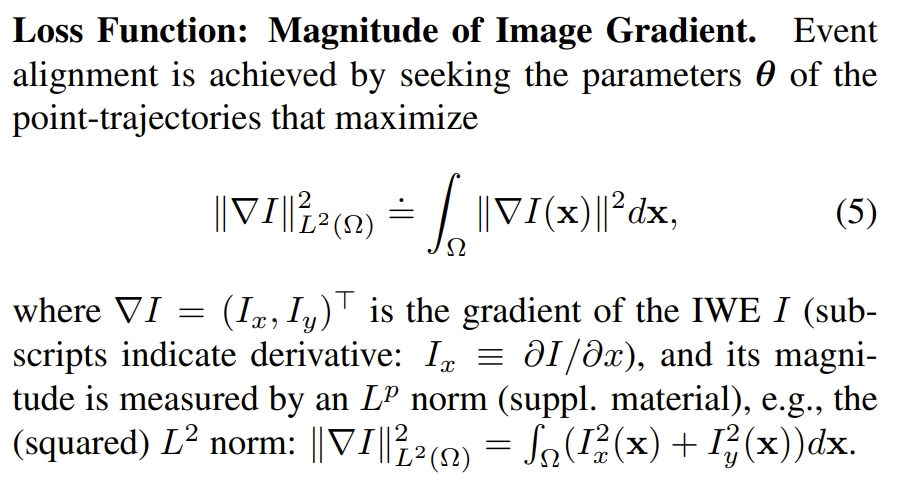

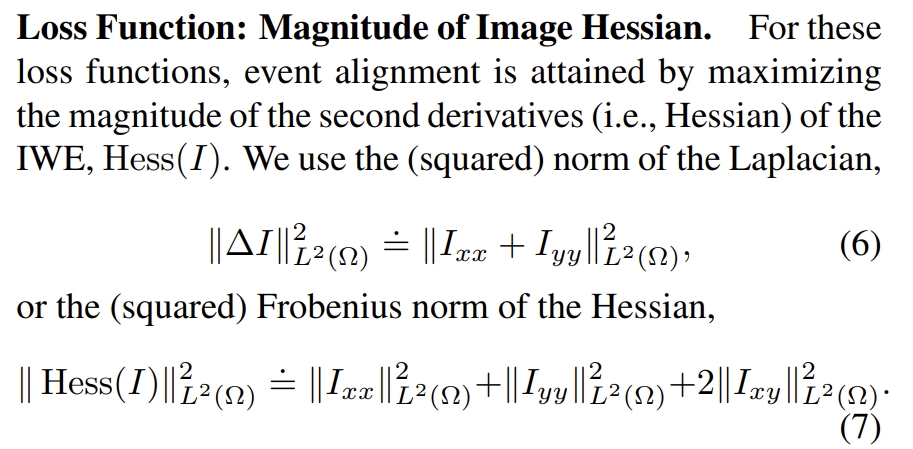

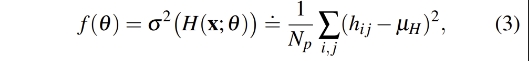

loss function

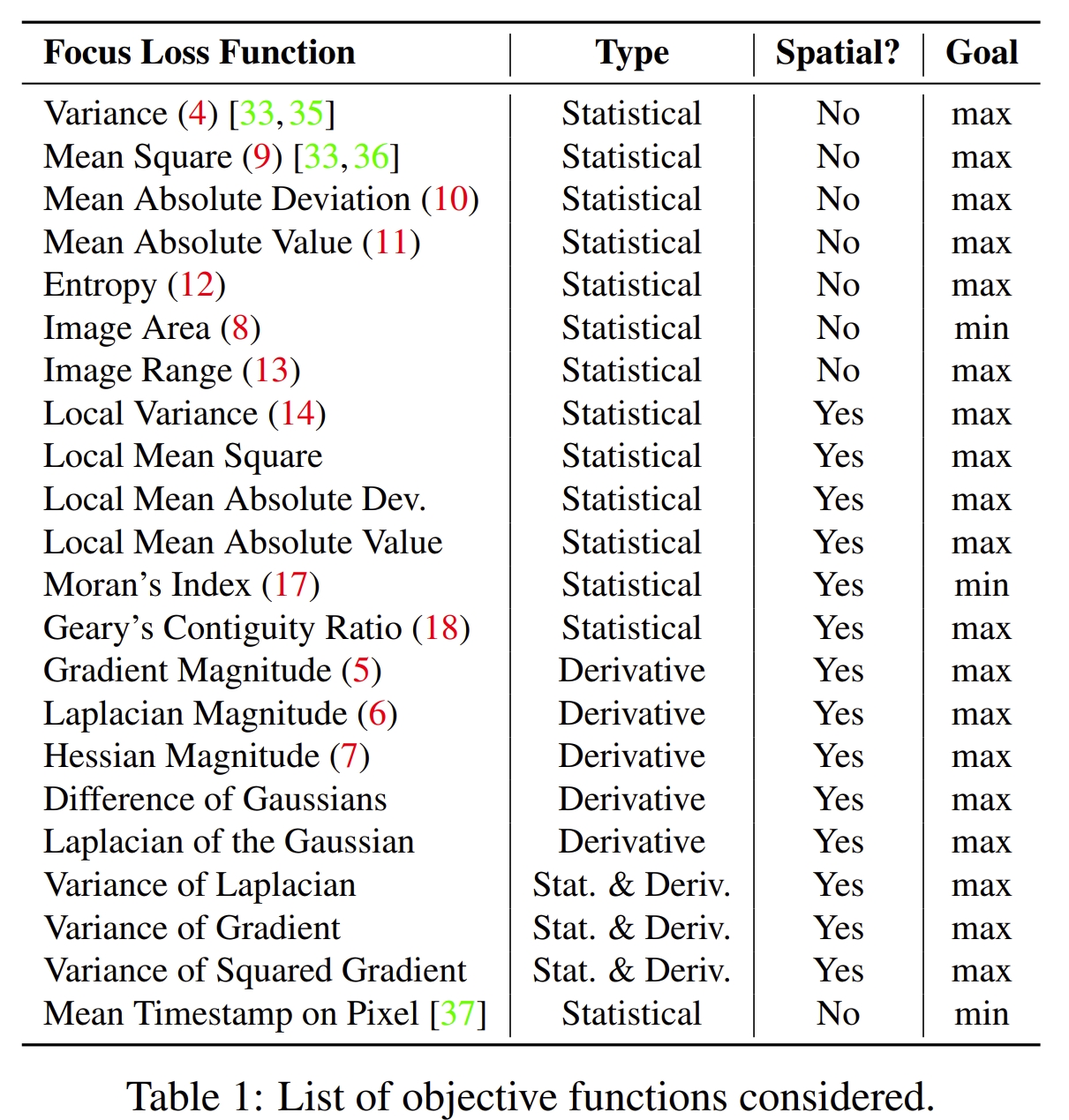

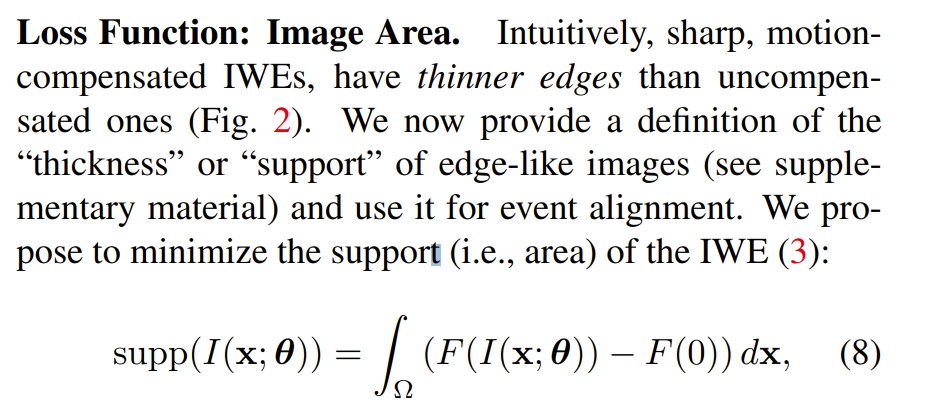

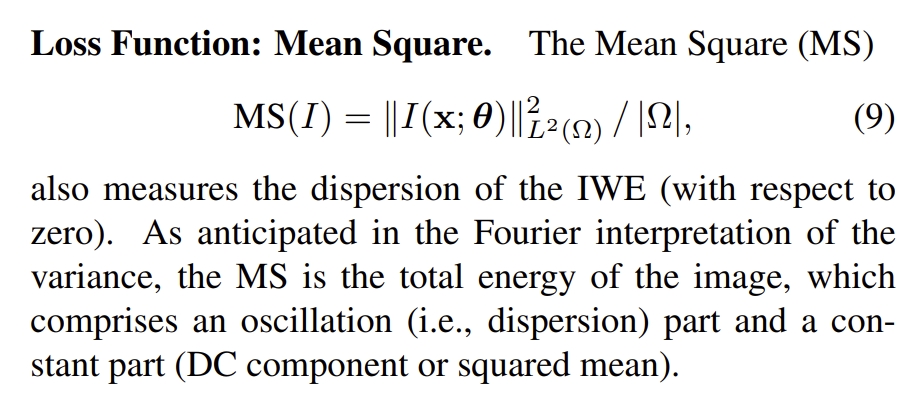

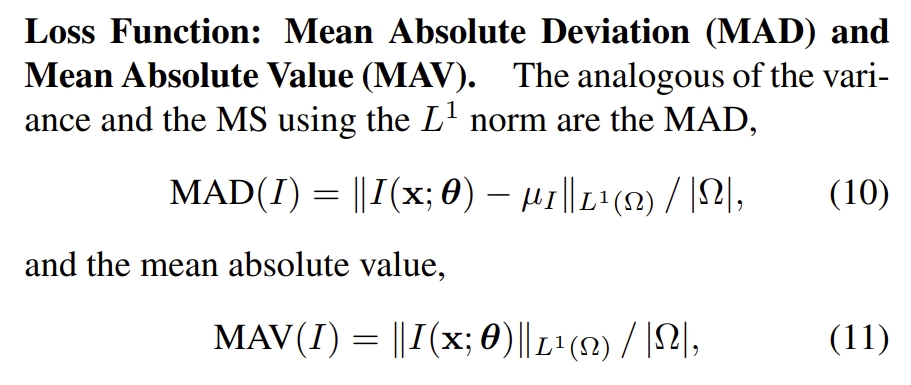

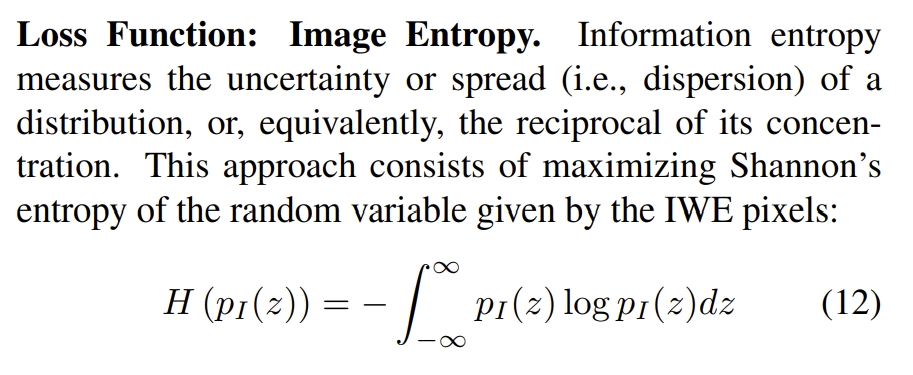

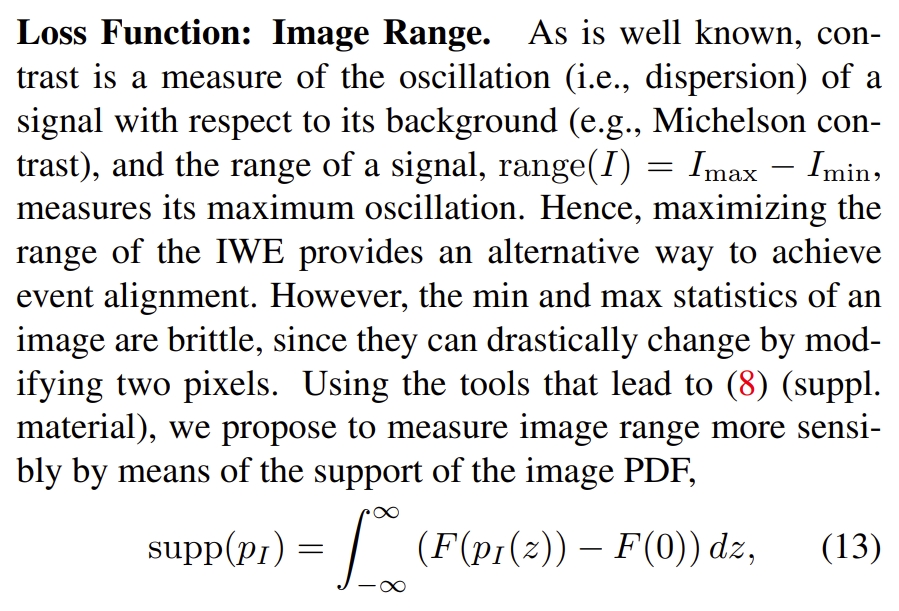

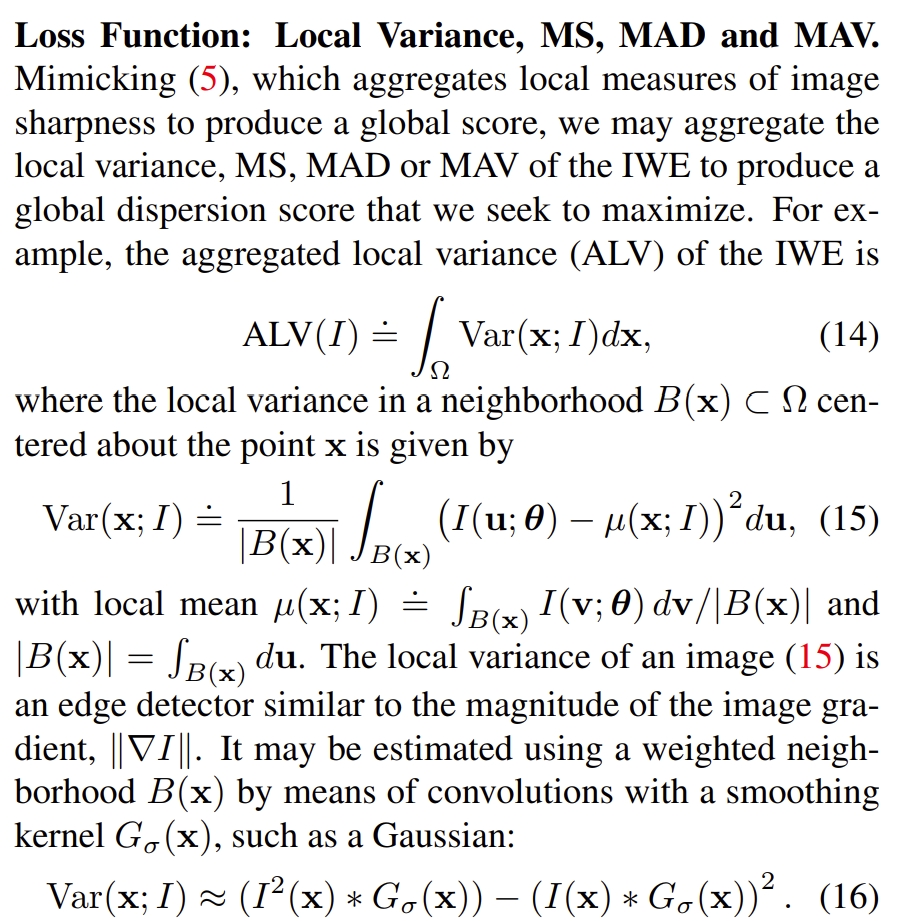

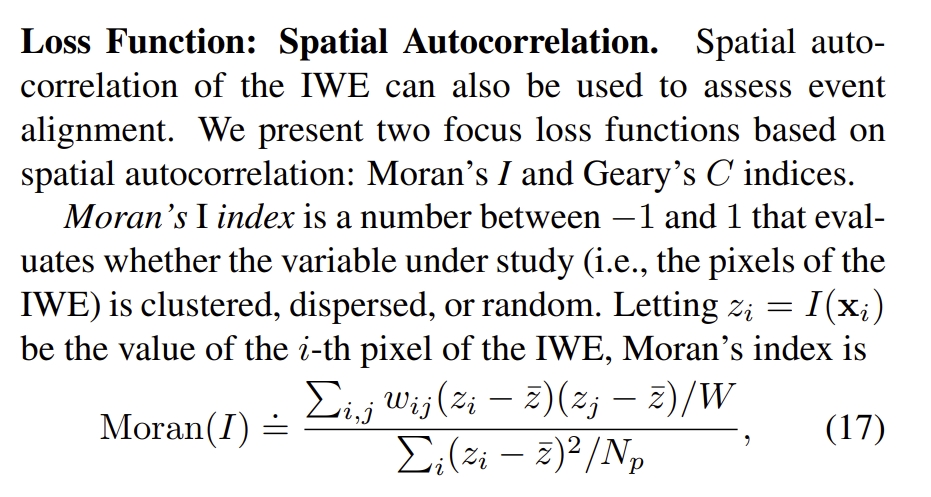

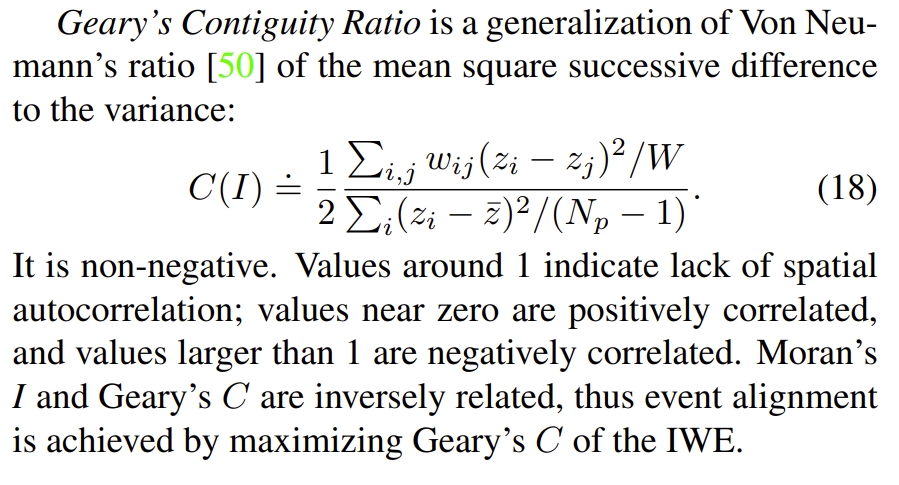

Focus is all you need: Loss functions for event-based vision (CVPR2019)中,介绍了基于CM框架的22个目标函数,不过这篇论文中是针对Motion Compensation这个主题的。

所谓的loss function其实就是Rotational motion estimation,motion estimation in planar scenes, Depth estimation, 和 Optical Flow estimation几个section中提到的公式3,就是上面CM算法框架图中描述的measure event alignment.

汇总如下:

对应的公式如下(实在太多了,只能是真正开发的时候要用到再细读了hh~):

|

|

|

|

|

|

|

|

|

|

|

此外,论文《Event Cameras, Contrast Maximization and Reward Functions: An Analysis (CVPR2019)》也是对各种loss function(此处换称呼为reward function)进行了分析,不过当然20多种那么多了。

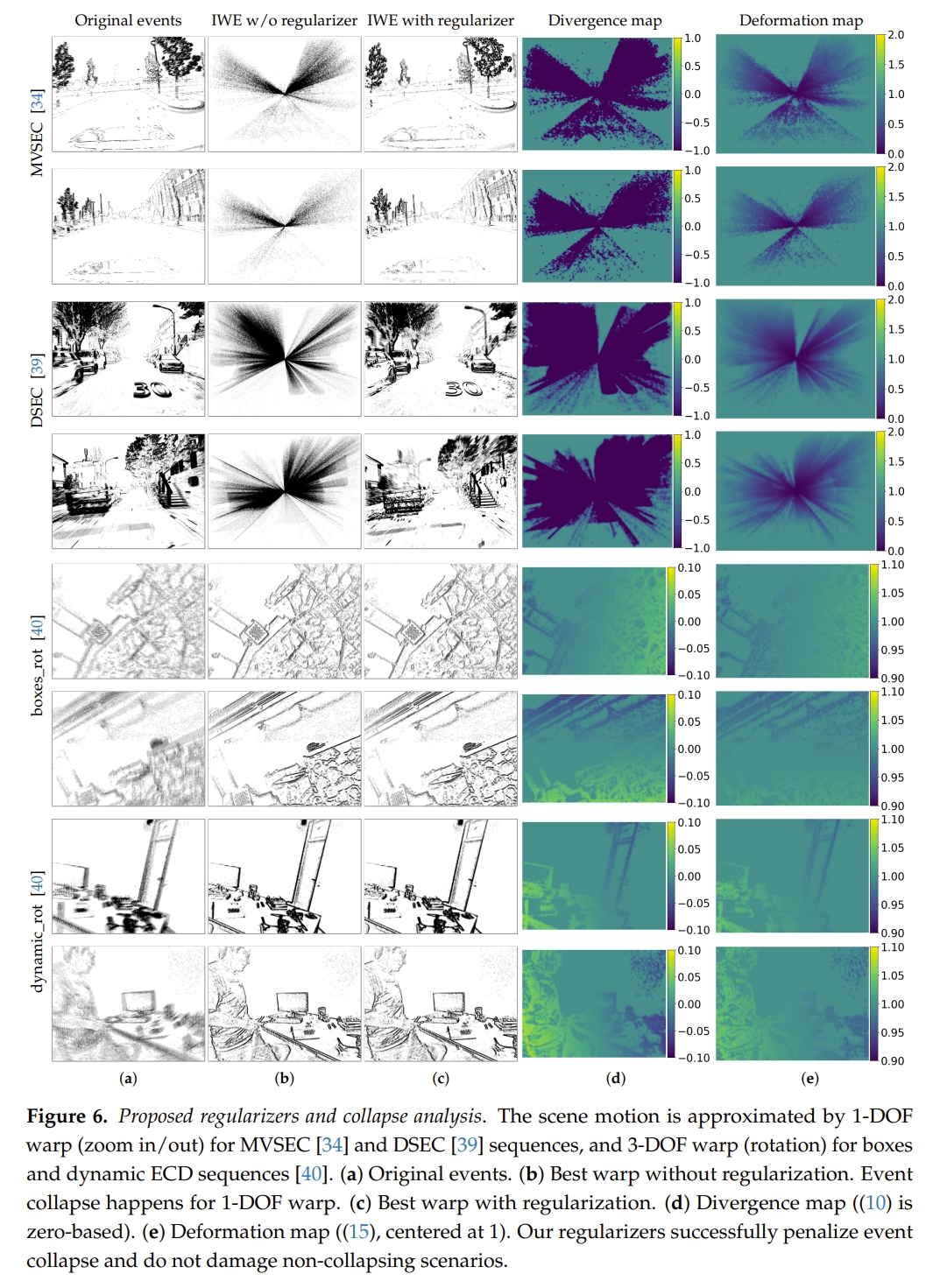

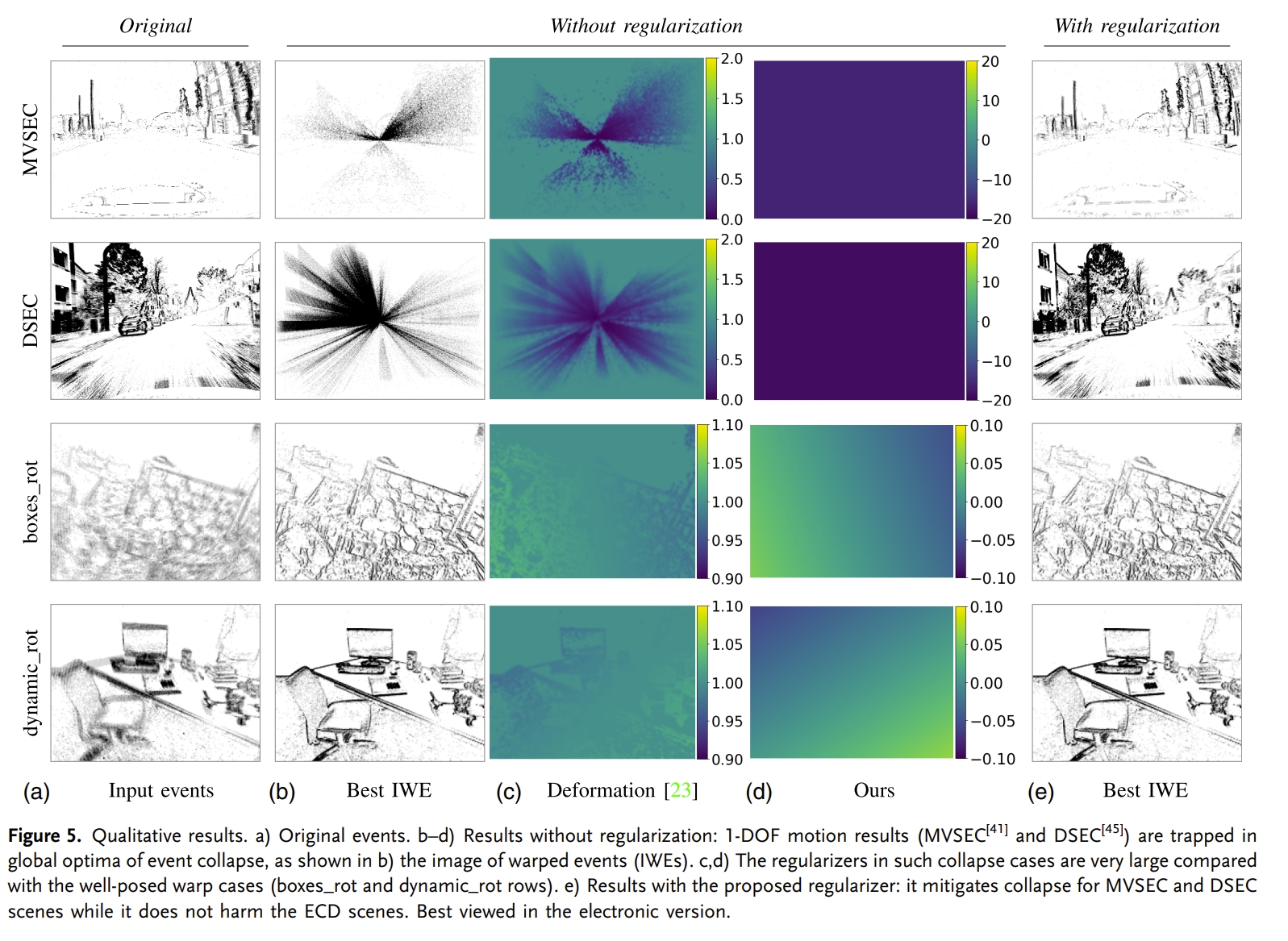

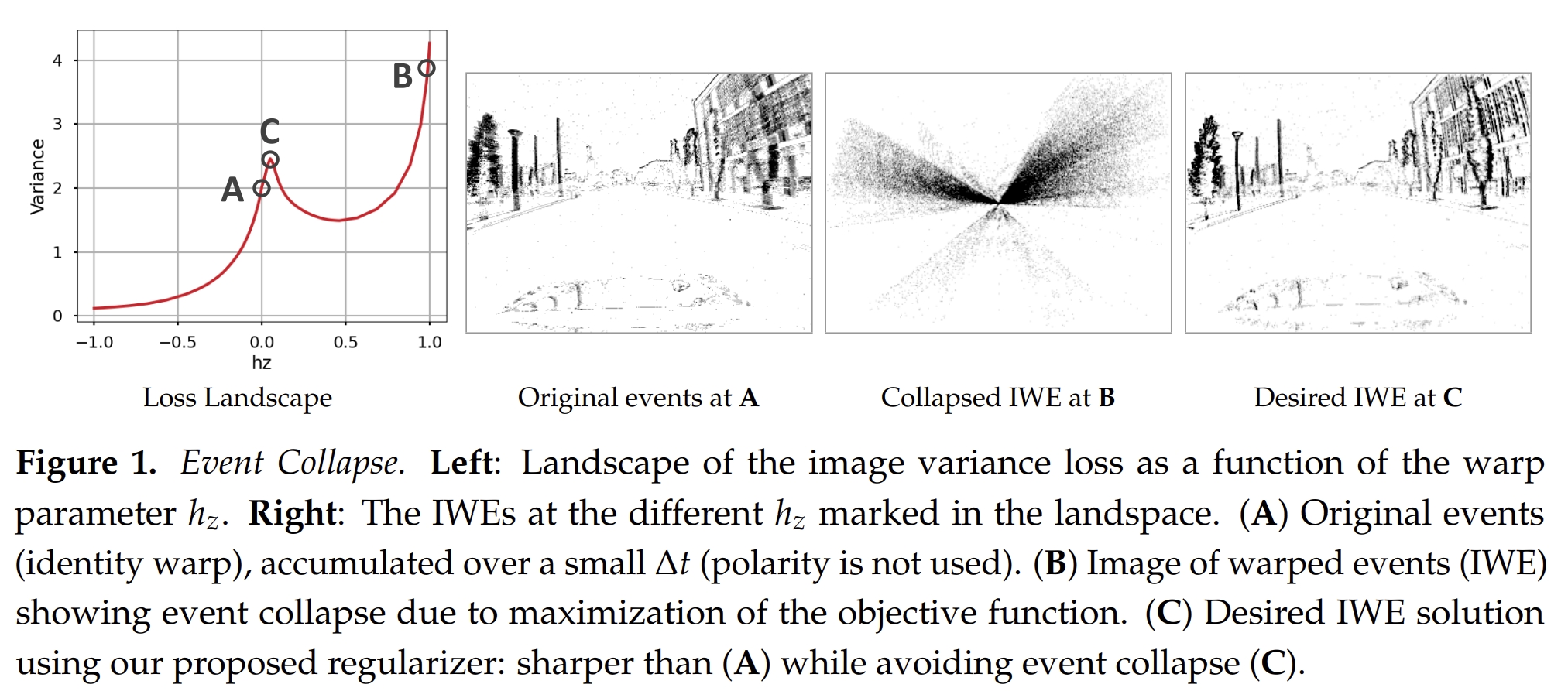

Event Collapse

所谓的Event Collapse直译就是“事件崩溃”(也有称为over fitting),表现出来的线性就是事件被warped到少数的pixel区域(events accumulate into too few pixels),也就是退化/失真,场景中的事件被投到一块(陷入所谓的局部最小值了),而Prof. Gallego团队的两篇论文Event Collapse in Contrast Maximization Frameworks (Sensor 2022)和A Fast Geometric Regularizer to Mitigate Event Collapse in the Contrast Maximization Framework (AIS2023)的研究也证明,添加正则化项是唯一的有效,消除Event Collapse的方案.

PS:说是两篇,我个人觉得是一篇,因为两篇论文的结果图也就是换个排序而已😂

从上图可以看到,甚至在单自由度(直线运动)的时候,也会出现event collapse。 实际上,如果是测过CMax-SLAM就会发现,除非对事件切分得很好,不然会出现大量的event collapse的情况~

除了正则化以外,解决event collapse的方式有:

- 把参数初始化为非常接近真值(

initializing the parameters sufficiently close to the desired solution)emmmm这点怎么说呢,简单说应该就是:给真值加个高斯noise然后让算法估算获得estimated value再跟真值对比(还真有顶会甚至TPAMI、TRO级别的这样做的😂) - 降低问题的自由度(但个人人为没啥用,毕竟实际中CM是在1D下也可能出现event collapse),也有通过global optimal或者通过设置 reward functions的upper and lower bounds来实现更好的效果的

- 采用其他传感器提供更多约束(比如深度图)

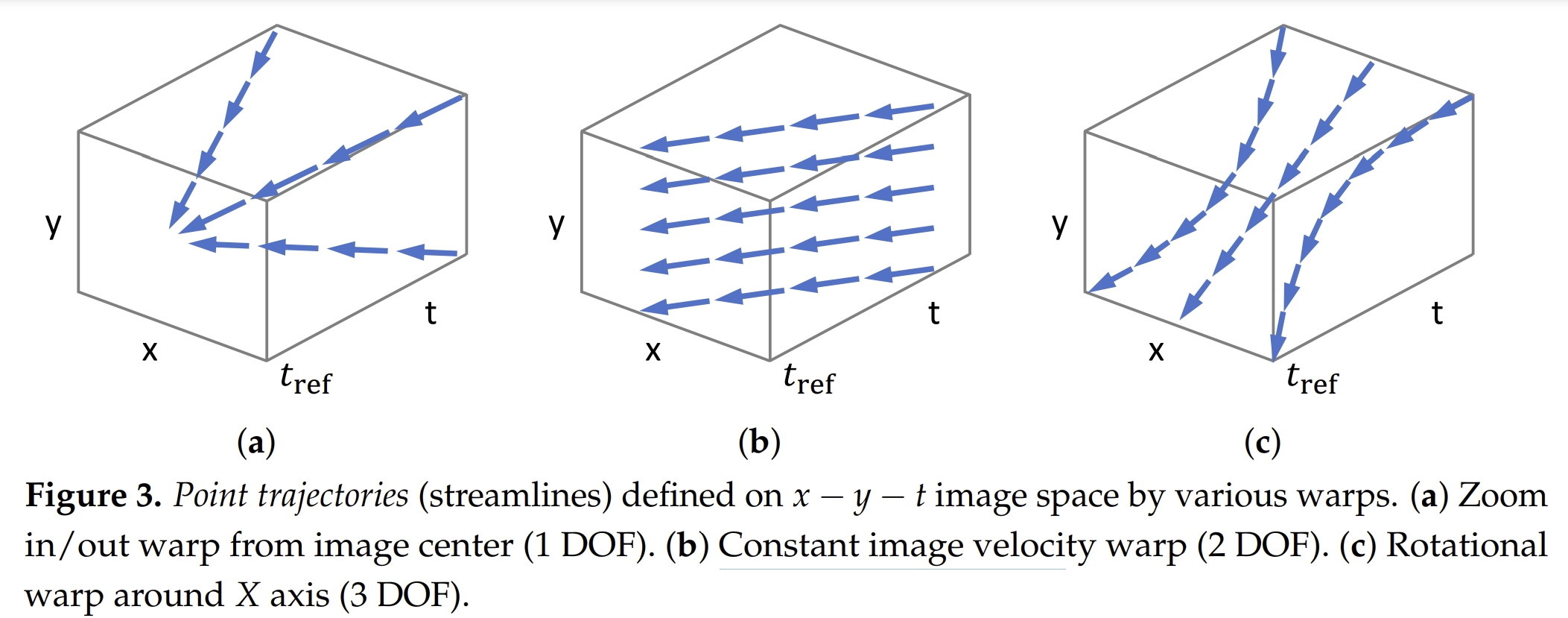

如下图所示,

If the warp does not enable event collapse (contraction or accumulation of flow vectors cannot happen due to the geometric properties of the warp), as in the case of feature flow (2 DOF) (Figure 3b) or rotational motion flow (3 DOF) (Figure 3c), then the optimization problem is well posed and multiple objective functions can be designed to achieve event alignment

event collapse是由motion hypothesis(也就是wrap的模型)来决定,某些运行(比如光流或者rotational motion)是不会产生event collapse的

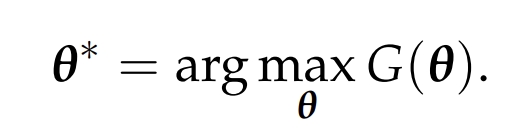

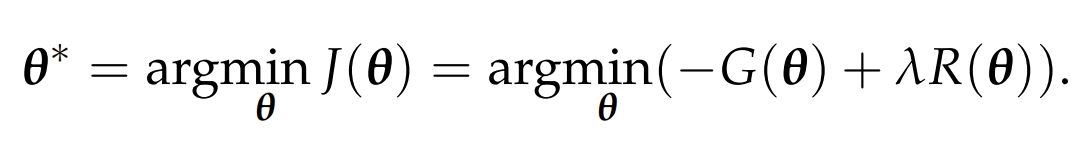

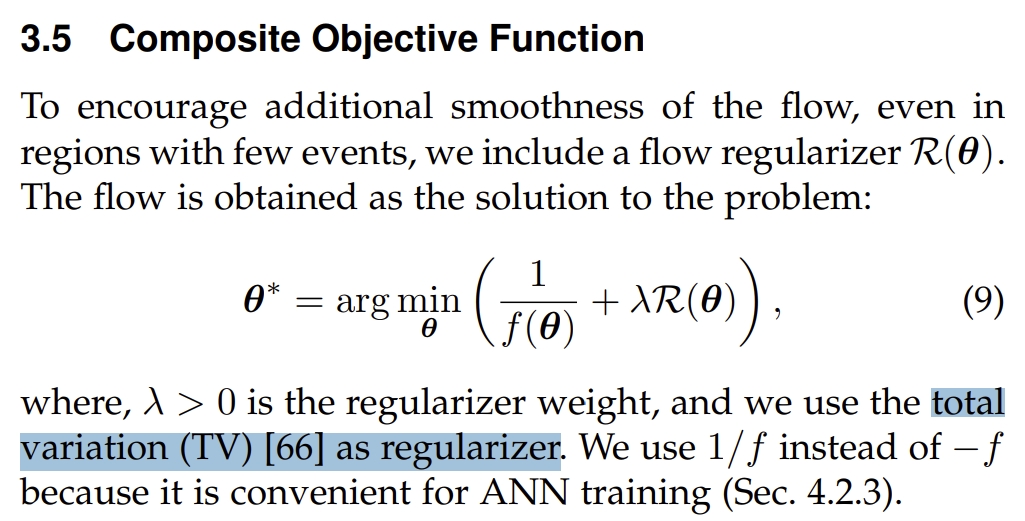

而所设计的正则化器也应该由motion hypothesis(也就是wrap的模型)来,因此对于下面构建的CM优化问题:

所谓的正则化则是把优化函数改为以下的形式:

而针对不同的运行模型正则化函数R是不一样的。具体的推导分析请见原文了。 不过在该作者的最新的工作中Secrets of Event-based Optical Flow, Depth and Ego-motion Estimation by Contrast Maximization (TPAMI2024),前面两篇工作的正则化器全部不用😂,直接改为采用total variation (TV)

类似地,文献Density Invariant Contrast Maximization for Neuromorphic Earth Observations (CVPR2023)也针对1D和2D的运动来对CM框架产生的noise进行了处理,使得在更长的time windows以及高噪声下的CM算法恢复的图像更好,并应用到太空数据观测中。

CMax的主要应用

理论上CM框架可以用到所有的event-based vision的topic中,特别是以groups event的方式来处理event数据的。本质上CM是一个event processing framework.

此处主要列出的是基于CMax的原理来实现的framework,而不仅仅是作为数据处理的形式

Optical Flow Estimation

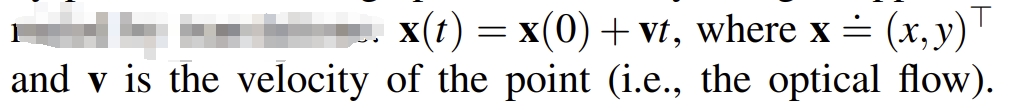

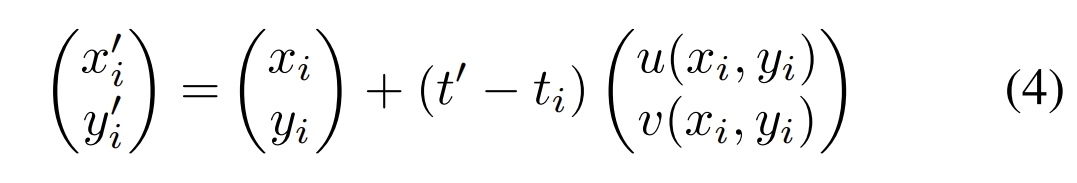

所谓的光流实际上就说每个pixel的motion vector(在小的时间段内)。而在理想的情况下(无穷小)在图像平面上的点的轨迹应该是一条直线,那么可以用下面公式来表达:

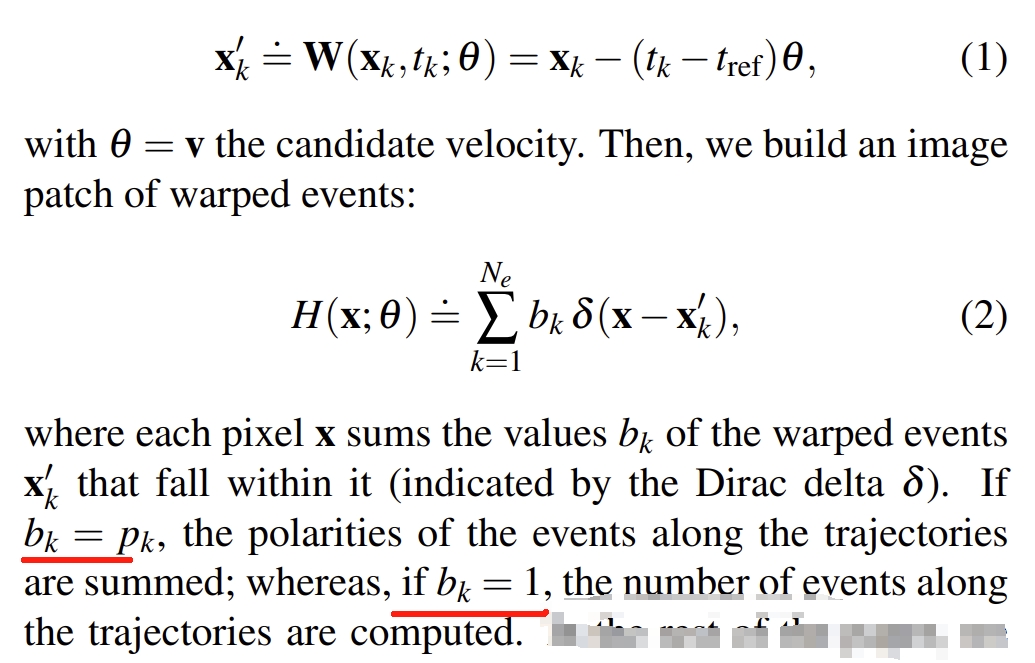

而数据关联的过程,就是把在这个轨迹(直线)上的事件给关联起来。 具体的做法则是: 首先将event累积在一起,通过proposed trajectories将他们warp到参考时间tref下:

公式2其实可以看成event累积的image(an image patch of warped events),求它的方差就可以得到下面公式

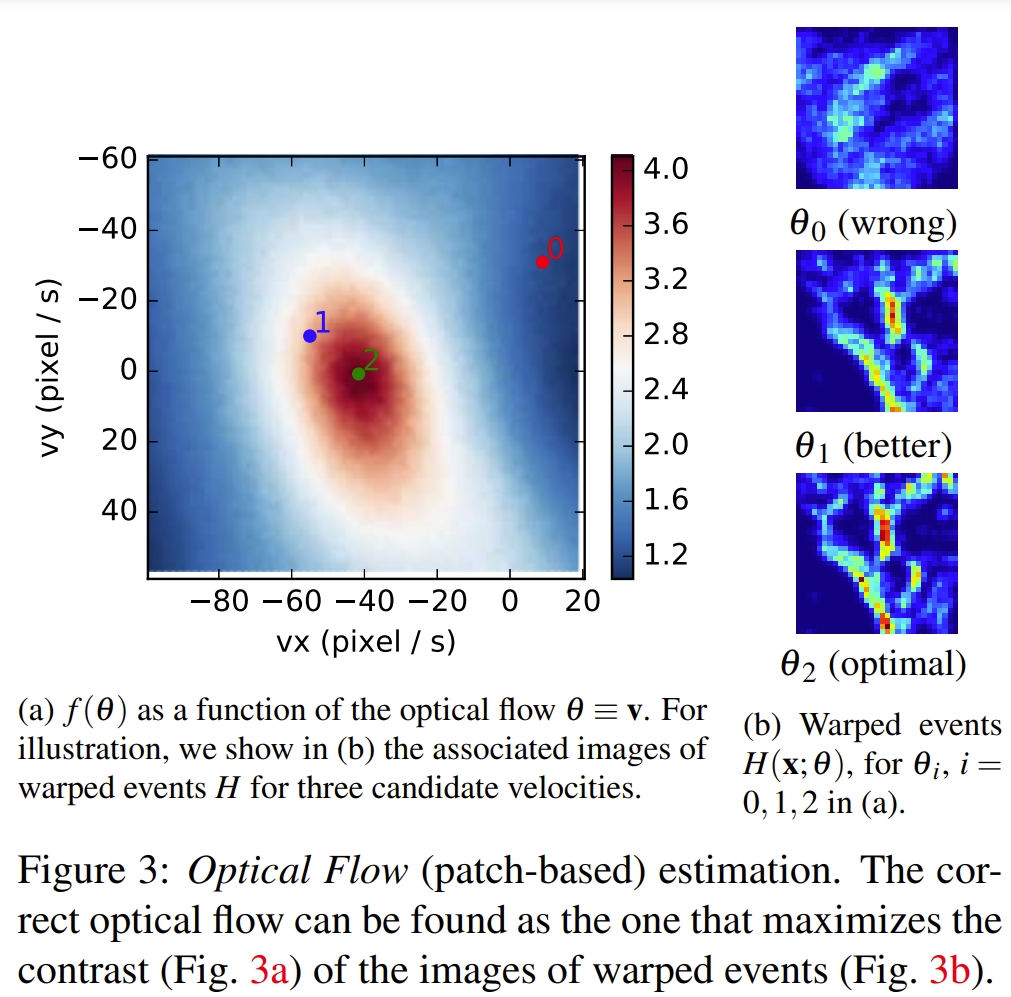

θ,也就是光流速度,可视化为heat map(如下图所示),可以看到它是smooth以及有明显的峰值的。并且在针对不同的θ,对应的IWE(image of warped event)也可视化到右子图中了。可以看到更高的方差对应IWE更高对比度(更sharp)。因此估算光流的问题可以转换为通过上面公式3(最大化方差函数)来寻找θ参数的过程。

PS:因为这个求最优的过程,其实也就是对于IWE要求对比度(contrast)最大,因此这个方法命名为contrast maximization

对于上面公式2中bk,作者在附加材料link中做了深入的分析。

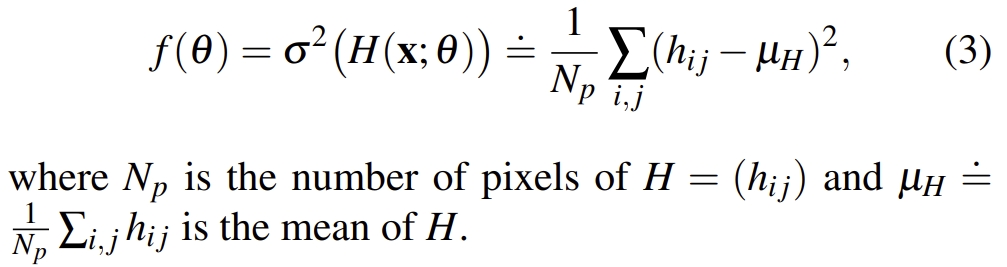

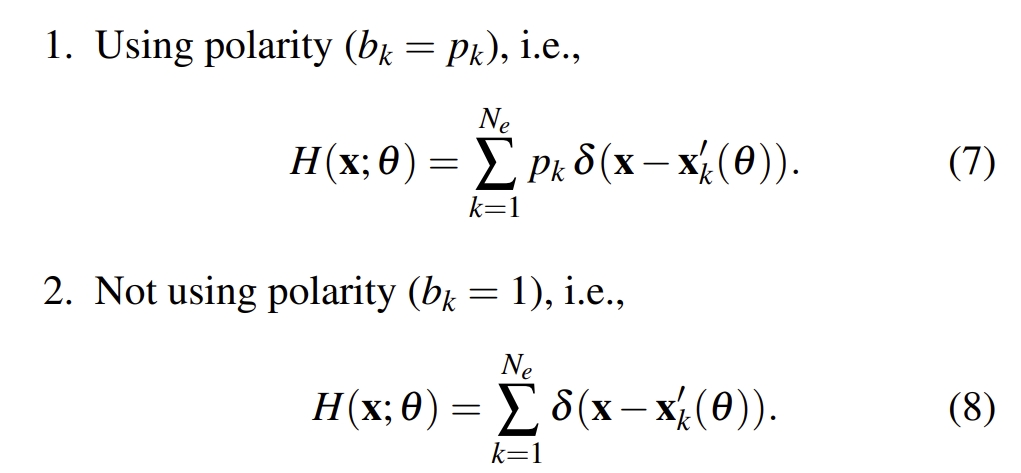

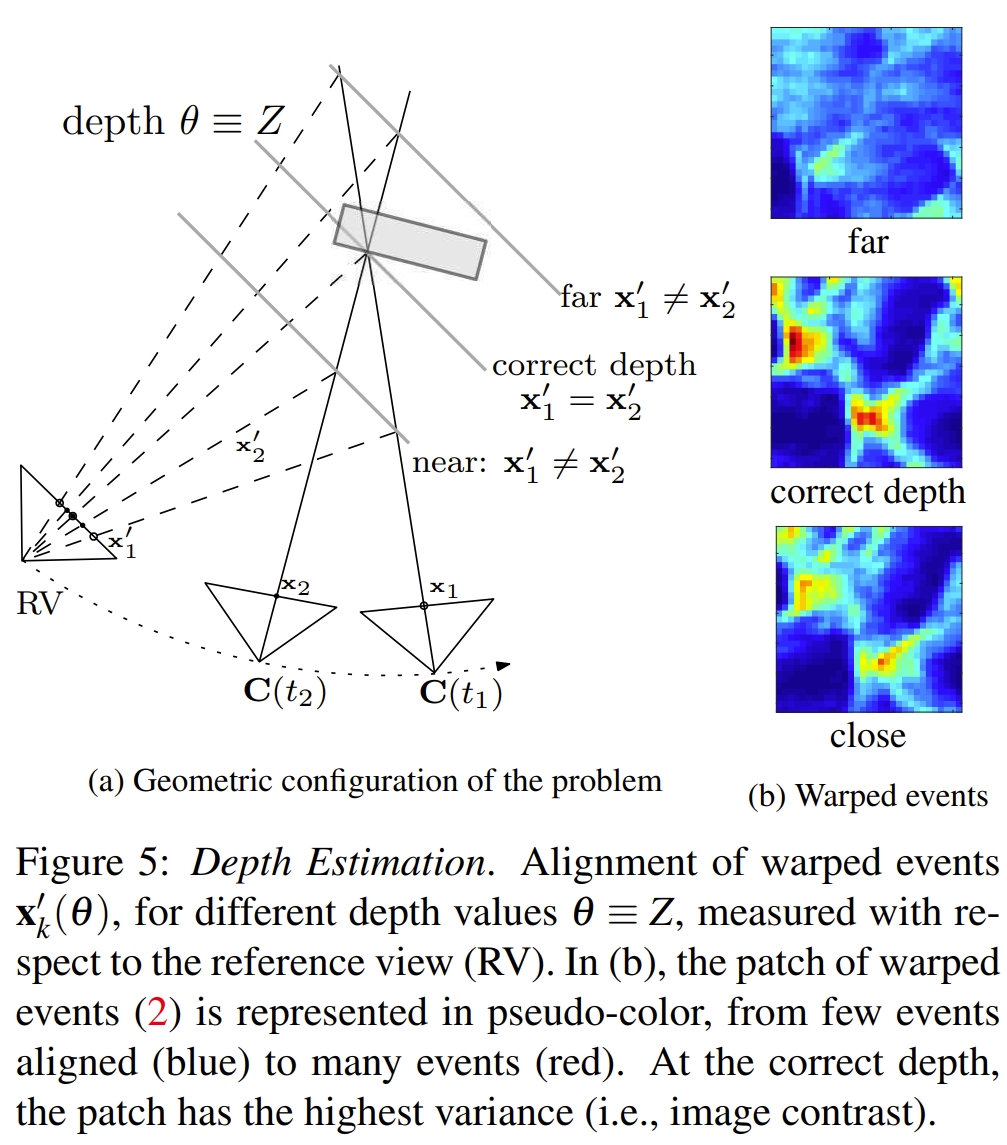

所谓的考不考虑极性是指在计算IWE的时候的公式2,对应下面两个公式:

效果如下图所示.首先从优化函数来说,是否使用极性的优化速度是近似的。但是采用了极性显然中间部分要明显一些,可以理解为更集中(optimal value is slightly narrower and more pronounced)。 而通过IWE的对比分析则发现,如果带有极性,会使得 contrast function(公式3)下降得更加明显(因为存在正负极性相抵消)

Depth Estimation

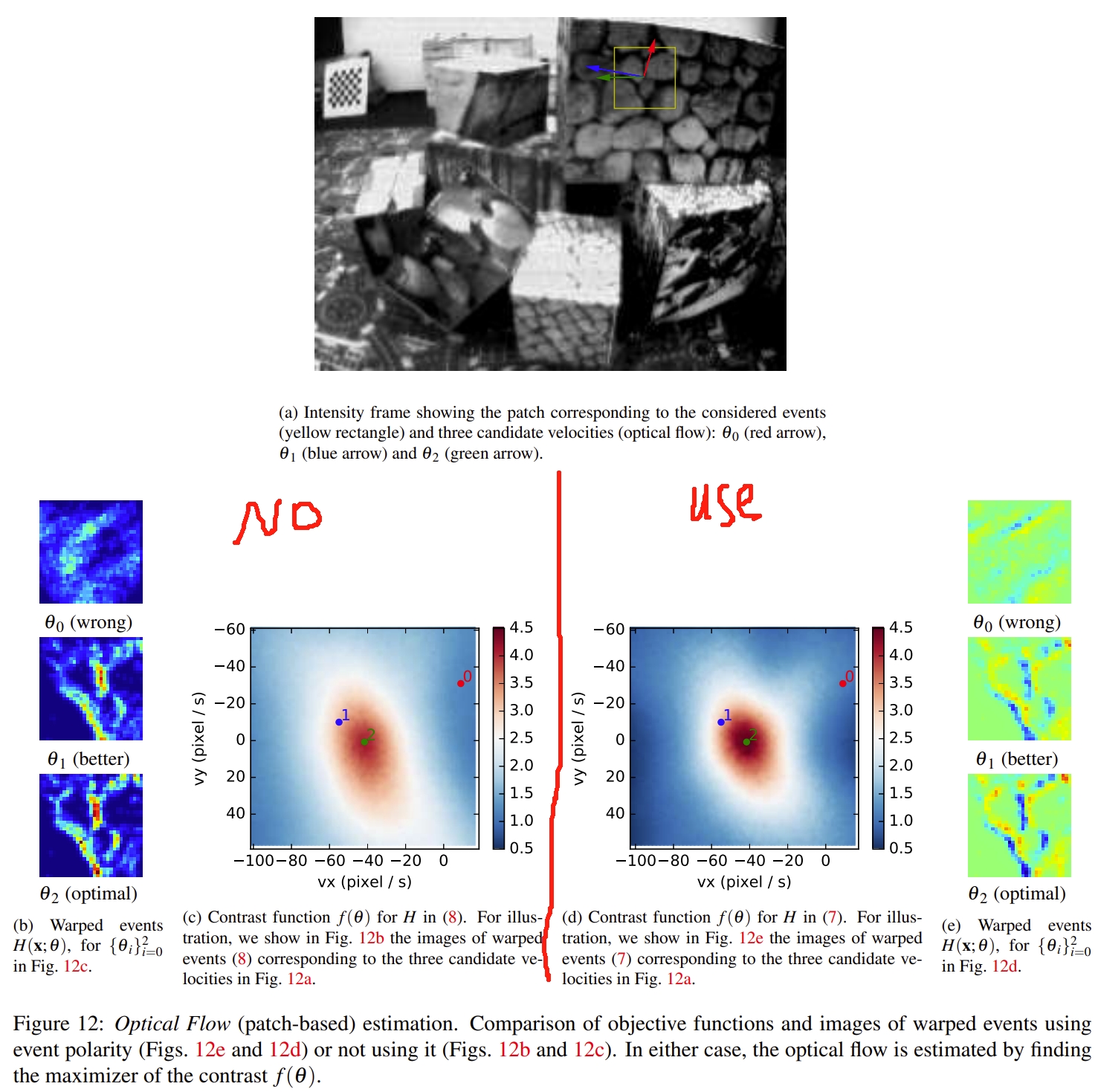

此部分是基于EMVS的框架的. 首先相机的pose、intrinsic都是是已知的。

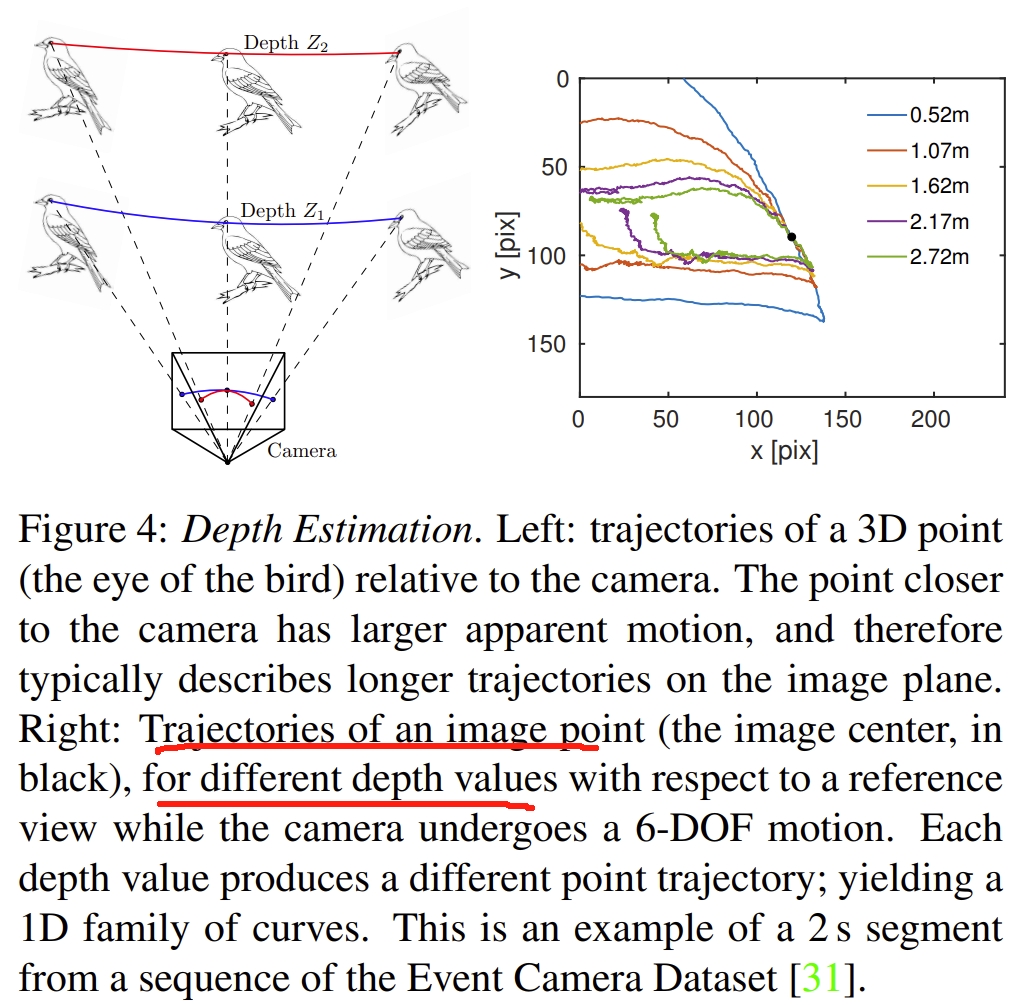

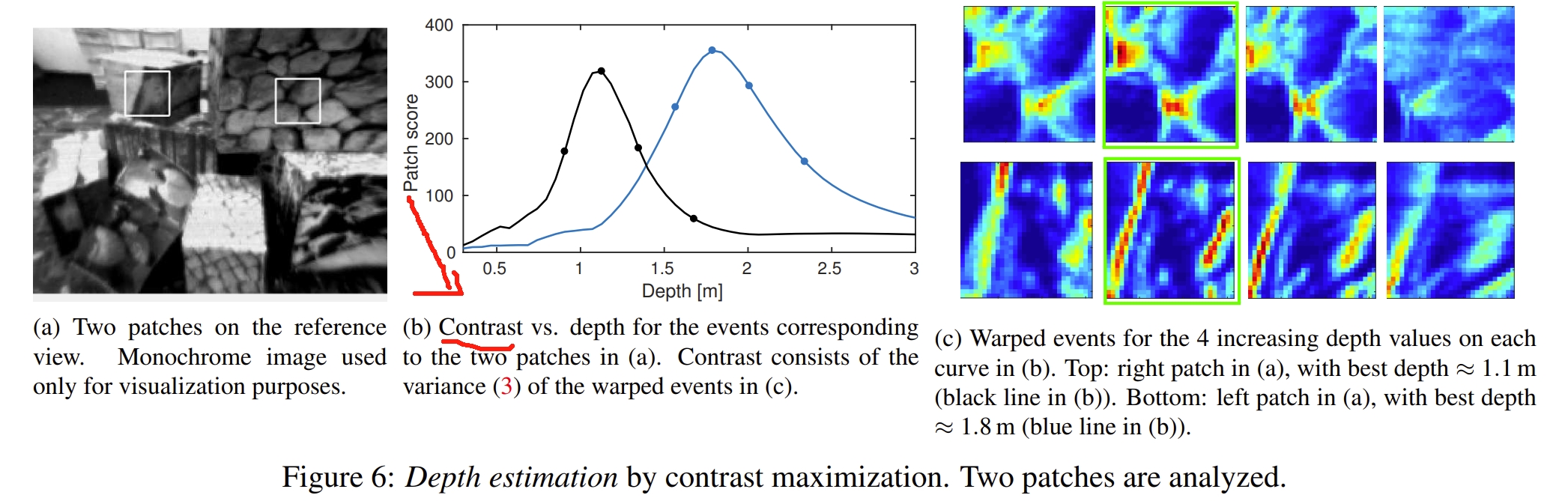

其次,其 geometric model 为:一个图像点的trajectory可以通过将一个3D点(同时有已知的6 DoF相机pose和相对于参考视角下3D点的深度)进行投影获得的。如下图所示。此时参数θ为深度,假设一个小的区域(patch)内所有的点都具有相同的深度。

|

|

基于CM框架下的深度估计步骤如下:

- Transfer the events (triggered at the image plane of the moving event camera) onto the reference view using the candidate depth parameter. 对于一个事件点 ek 采用 warp (W) function转换到e’k=(x’k,tref,pk)下:

然后,类似于上面公式2(也就是下图公式),通过计算沿着candidate point trajectory事件的数量

- 通过测量上面获得的图片的对比度(或者说方差)来测试event以及depth value θ的匹配对:

- 最大化对比度来获取深度值θ

下图通过可视化两个patch的优化过程来看CM算法的深度估计效果:

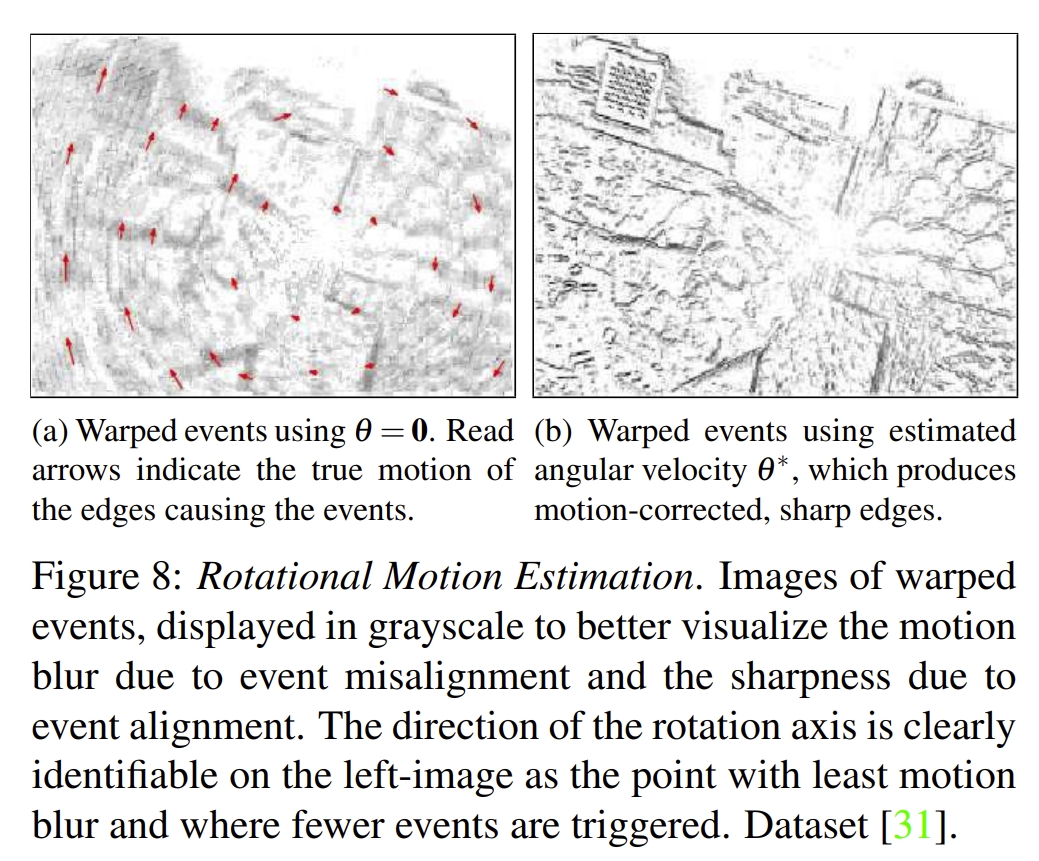

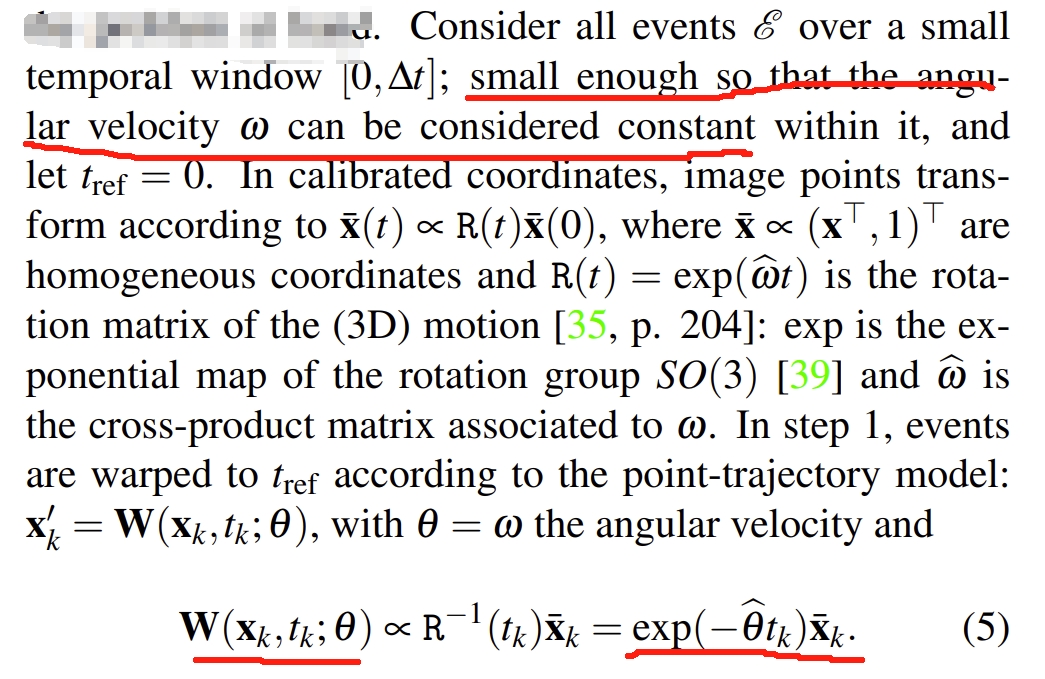

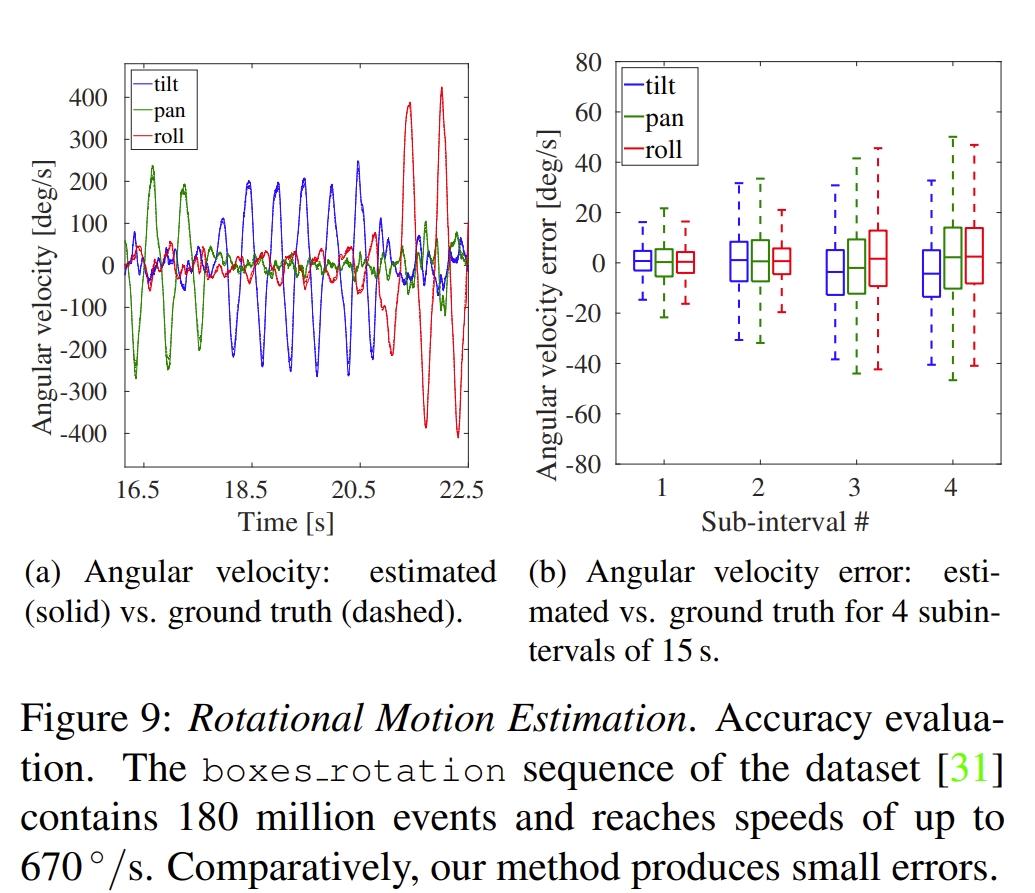

Rotational Velocity Estimation

这其实是角速度的估计,最经典的应该是这篇工作《Accurate angular velocity estimation with an event camera (RAL2017)》

首先,此任务是针对在静态环境下相机仅有rotational motion的,同时相机的intrinsic也是已知且去失真~

- 其 geometric model如下:

- 通过下面构思构建 image of warped events

- 更前面两个子任务一样,采用下式来构建优化方程

估算的角速度的精度还是比较高的~

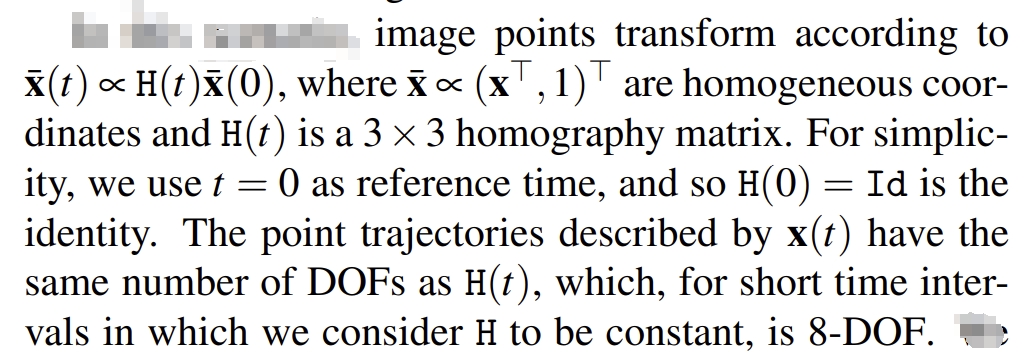

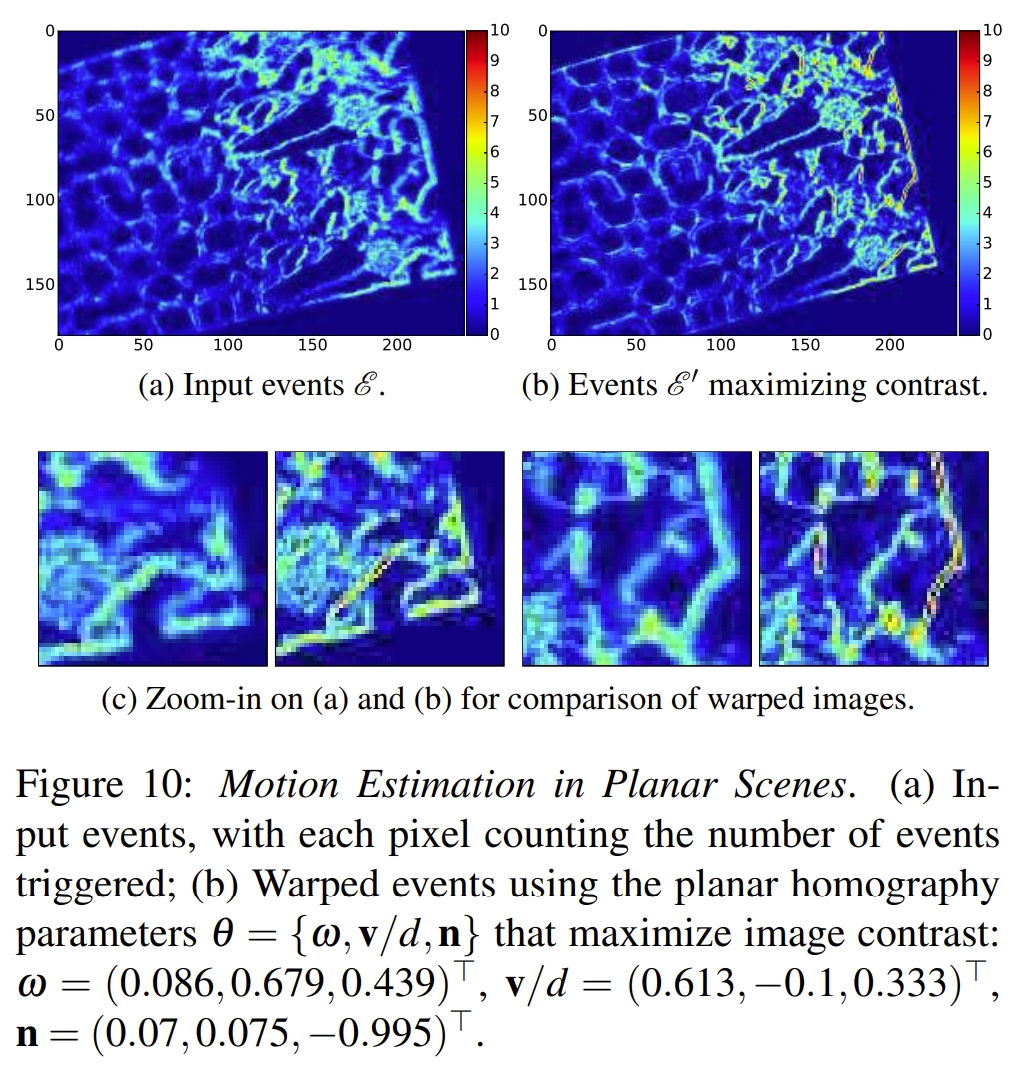

Motion Estimation in Planar Scenes

这是在平面下的rotation 和translation运动估计,属于3 DoF吧~

在此场景,图像点的变换如下:

同样地,采用上面的公式2和3来构建IWE以及求最优化

|

|

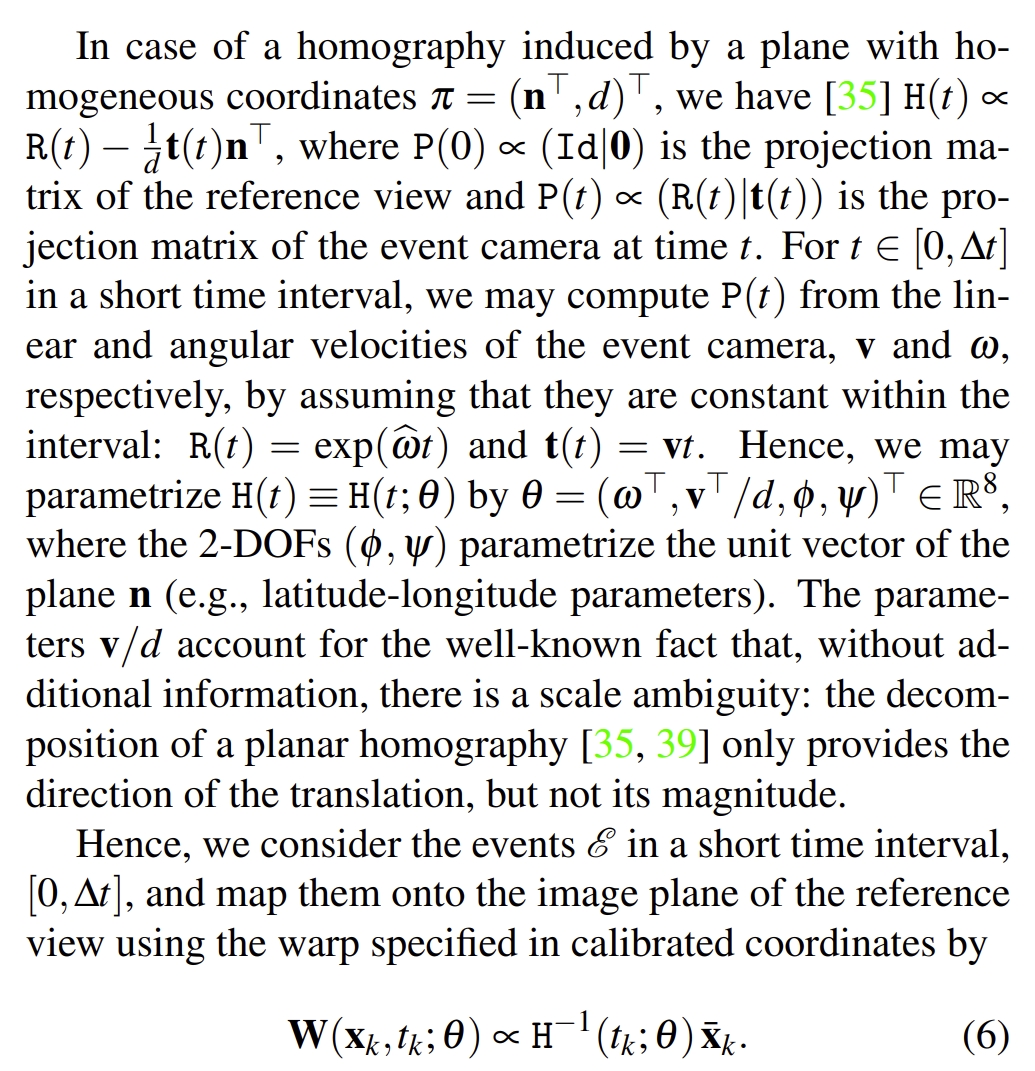

效果如下图所示:

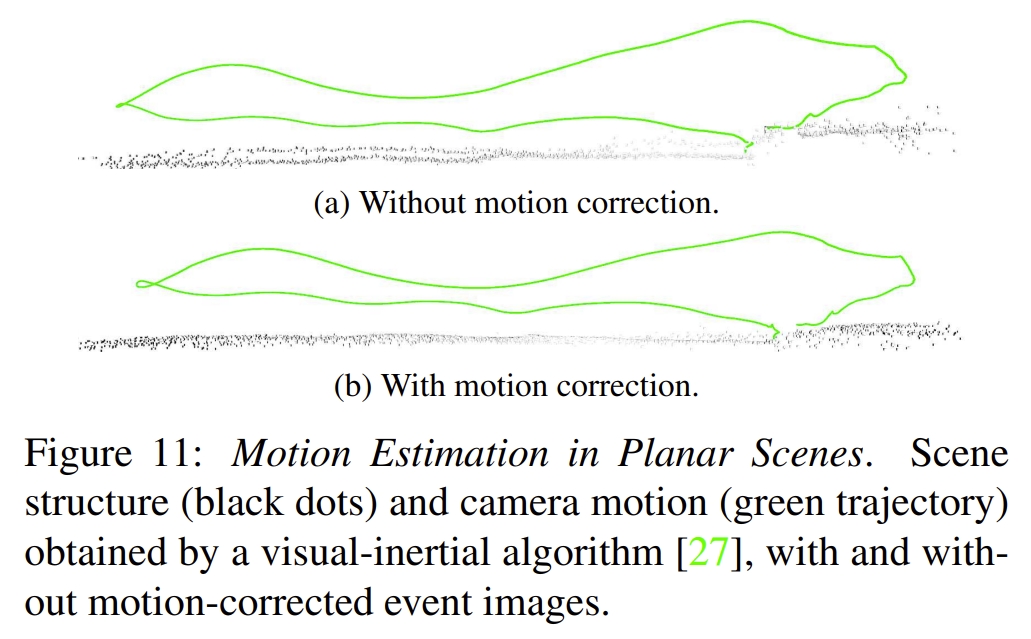

并且下图也展示了采用或者不采用CM框架下的VIO效果。可以看到采用CM算法恢复的平面点是要平整一些~

SLAM or 6DoF Pose Tracking

此处的基于SLAM的应用是指full-SLAM或6DoF Pose Tracking,因为大部分的CMax中所谓的motion estimation都是指 rotational 或者fronto-parallel motion estimation,这其实应用场景非常局限的,比如工作《CMax-SLAM: Event-based Rotational-Motion Bundle Adjustment and SLAM System using Contrast Maximization (TRO2024)》</sup>

文献ref则是是首次实现了将CM framework用到EVIO问题中;而更早的文献ref则是首次将CM框架拓展到EVO(event+image odometry)问题中,论文中也宣称首次拓展到6 DoF motion。

本质上这两个能基于CM实现6DoF Pose Tracking的基本原因都是仅仅用CM来作为运动补偿,并不是直接采用CM的原理来计算pose,受限于局部最优以及容易退化,基于CM原理的motion estimation一般都是限制在rotational 或者fronto-parallel motion estimation.

Learning-based Framework

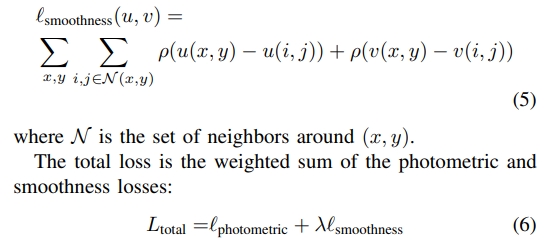

其中CMax framework也被广泛应用于deep learning中,特别地,是用来构建Self-Supervised Learning loss:

- Unsupervised event-based learning of optical flow, depth, and egomotion (CVPR2019)

- Back to event basics: Self-supervised learning of image reconstruction for event cameras via photometric constancy (CVPR2021)

- Self-supervised learning of event-based optical flow with spiking neural networks (NIPS2021)

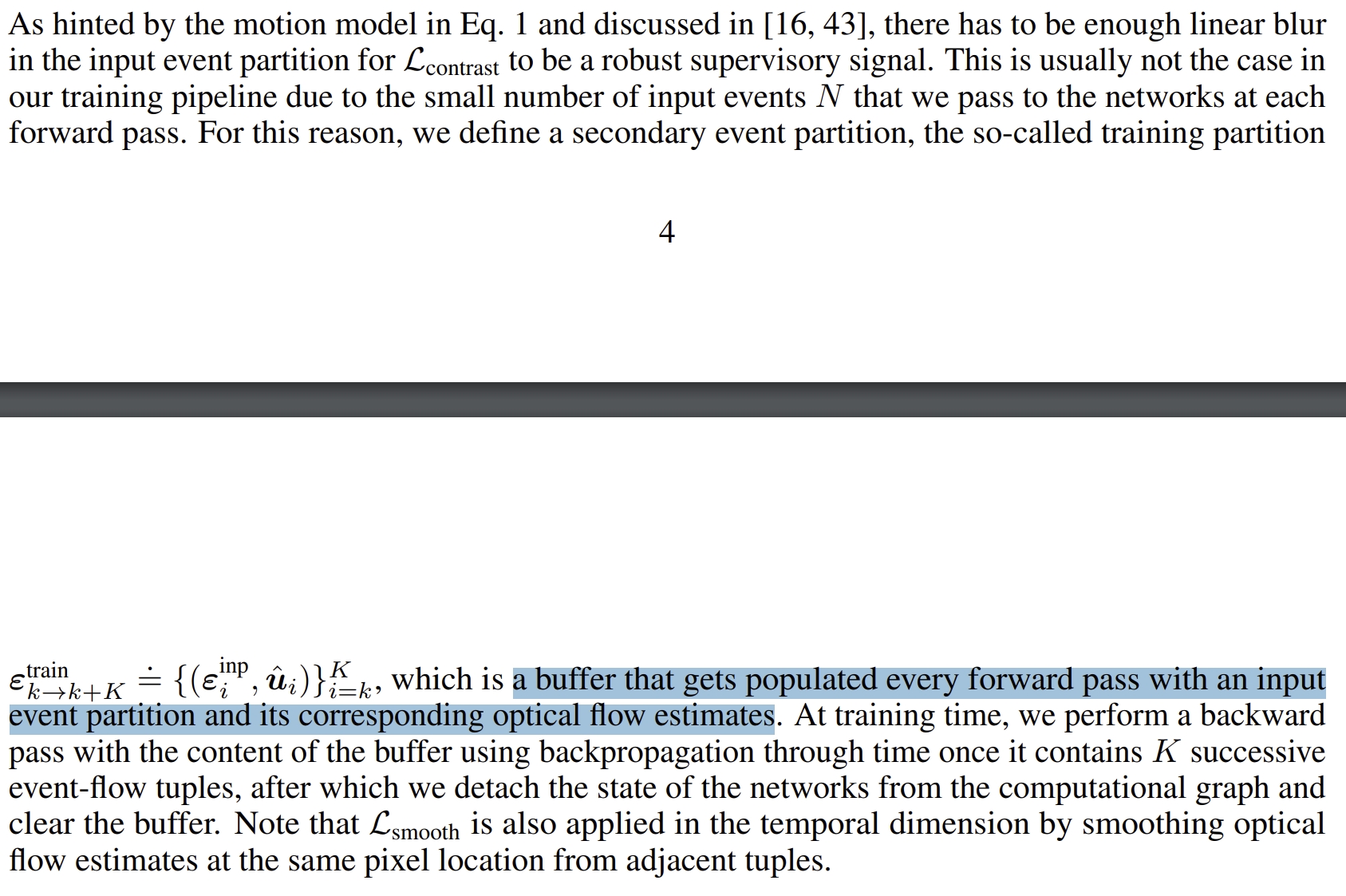

- Taming contrast maximization for learning sequential, low-latency, event-based optical flow (CVPR2023)

- Fully neuromorphic vision and control for autonomous drone flight (SRO2024)

- Motion-prior Contrast Maximization for Dense Continuous-Time Motion Estimation (ECCV2024)

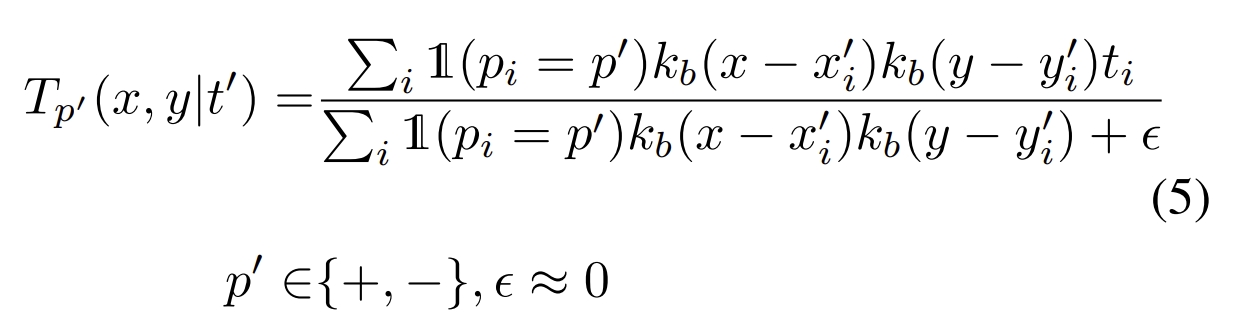

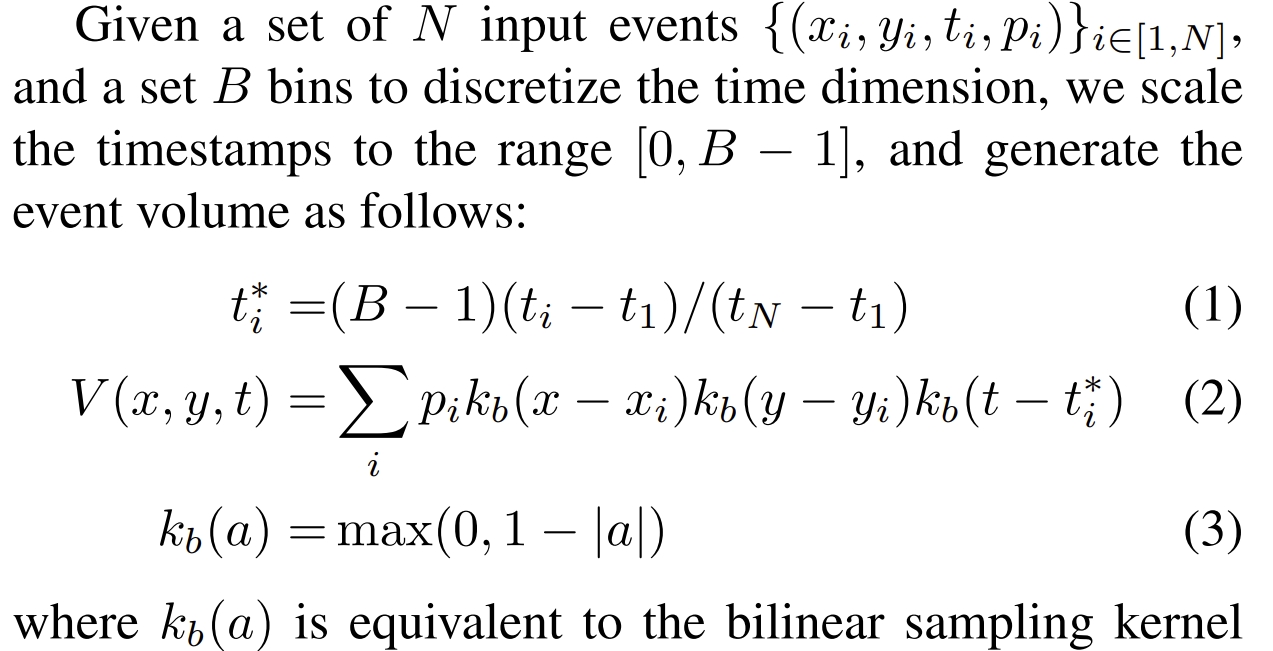

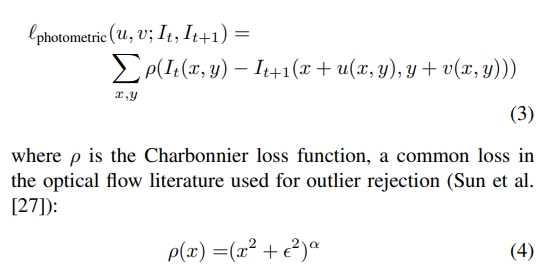

对于光流估算的网络,可以通过CM框架来实现Unsupervised或者Self-supervised learning(首次应该是在论文《 Unsupervised event-based learning of optical flow, depth, and egomotion (CVPR2019)》中提出的)。原理如下:

对于估算出来的光流:u(x, y), v(x, y)可以构建warp function如下:

如果网络估算的光流是正确的,那么就可以将这段事件内的事件都进行投影,获得的IWE的对比度是最大的。当然如果单纯用对比度最大化这个loss function,网络很容易overfit(应该也就是出现类似于Event Collapse)的情况。

the network would easily overfit to this loss, by predicting flow values that push all events within each region of the image to a line.

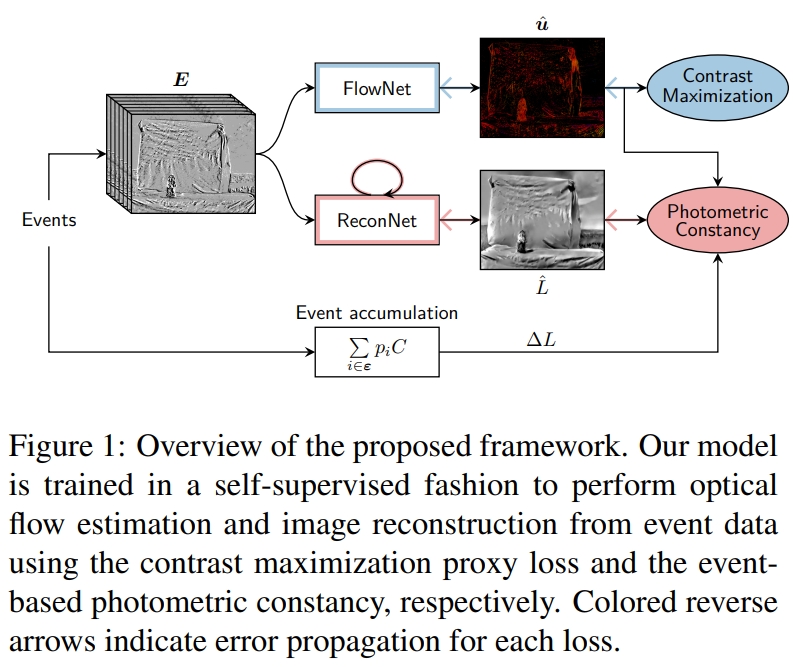

那么作者通过分离事件的极性,生成an image of the average timestamp at each pixel for each polarity:

而采用的最终的loss实际上就是两种图片的平方和:

再进一步的,使用这个参考时间t’会存在一定的尺度问题(对于离参考事件不一样的事件,梯度相差很大),那么就进一步的把loss转换为backwards 和 forwards也就是 t′ = t1 和 t′ = tN(可以理解为用头与为分别作为参考时间来warp):

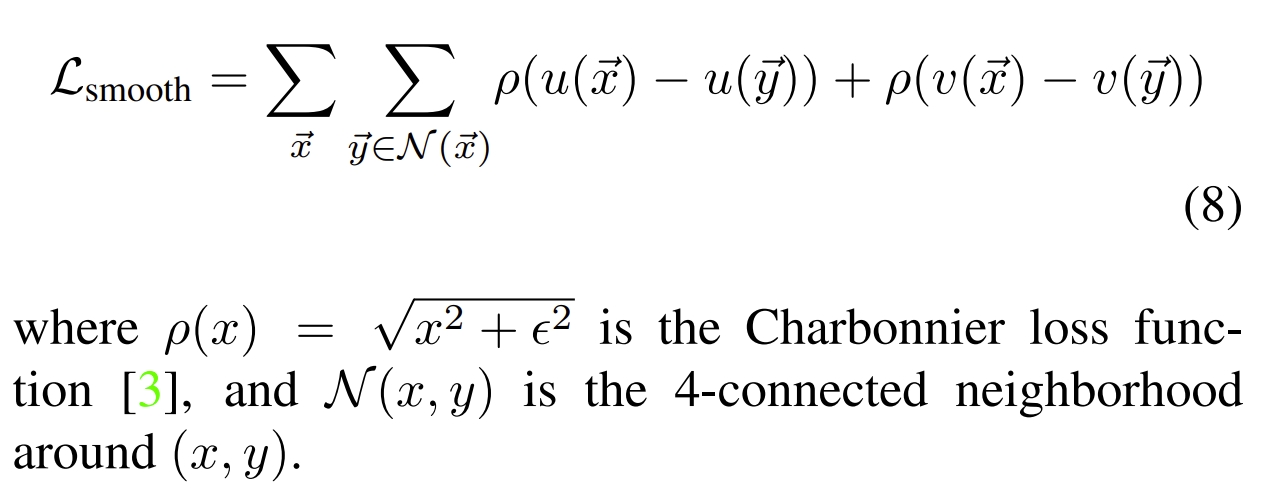

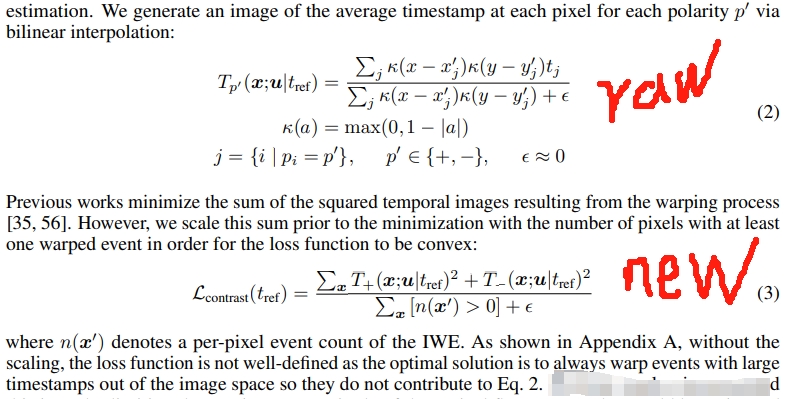

同时,在上面的contrast loss的基础上,额外引入了一个Charbonnier smoothness prior (local smoothness regularization):

其实论文《EV-FlowNet: Self-supervised optical flow estimation for event-based cameras (RSS2018)》Github也是用了类似的思路,只不过是基于photometric loss而已

|

|

论文《Unsupervised event-based learning of optical flow, depth, and egomotion (CVPR2019)》应该是CM用到self-supervised learning里面最经典的论文,不过可惜的是作者并没有开源代码,但是网上找到了一个非官方实现Github后续可以测试看看~

接下来论文《Back to event basics: Self-supervised learning of image reconstruction for event cameras via photometric constancy (CVPR2021)》实际上就是沿用了CM for SSL的思路,只是改为SSL估算的光流来监督image reconstruction,并且轻量化了这个光流网络

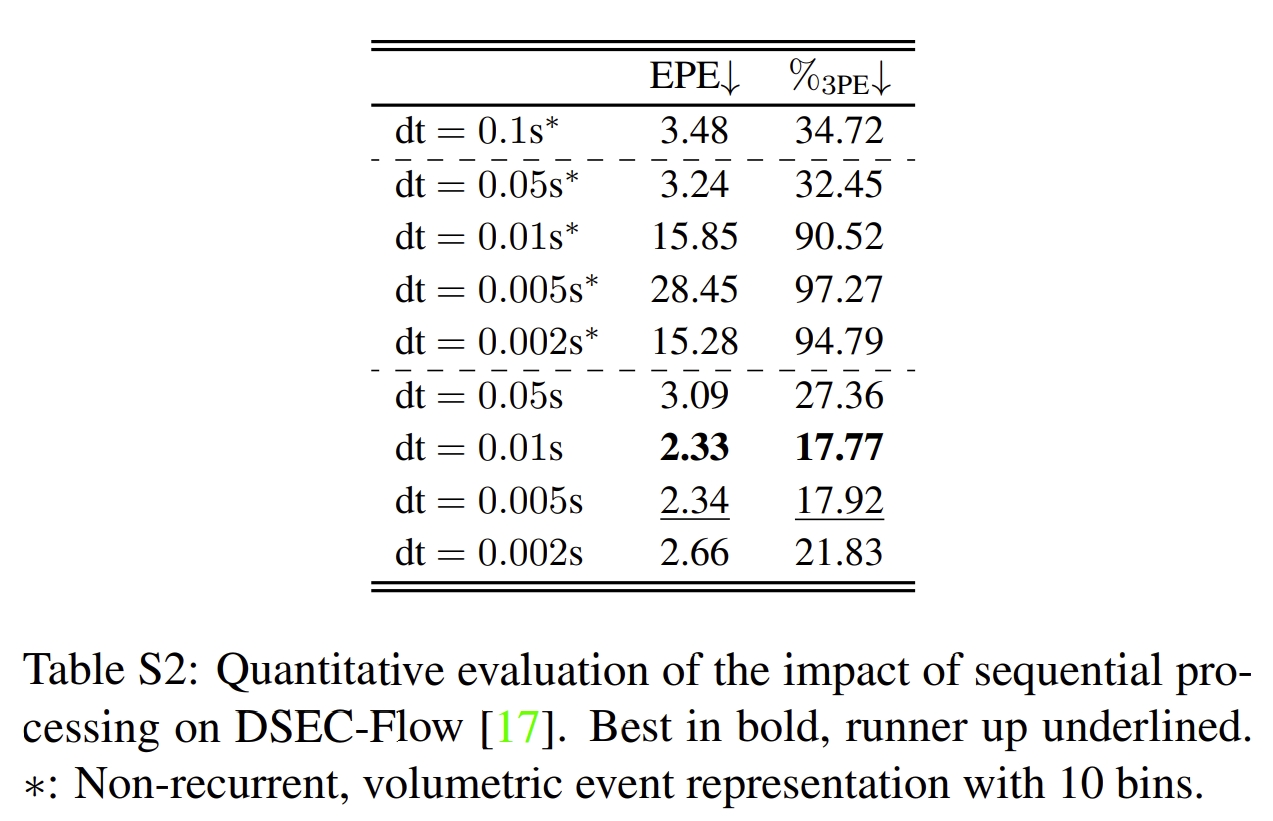

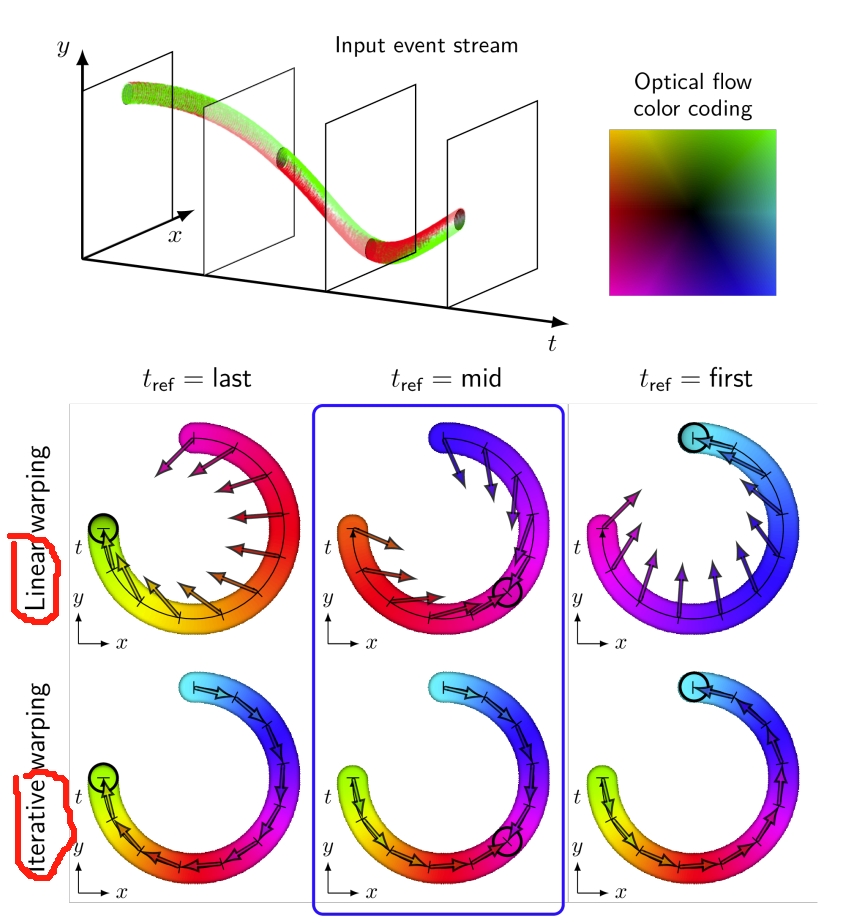

而在论文《Self-supervised learning of event-based optical flow with spiking neural networks (NIPS2021)》中作者则是把CNN改为SNN(Spiking neurons network)。 此外,作者也提到,每次输入的event需要足够的多才可以保证这个loss是有效的,但是如果是采用高频的处理以期获得高频的光流(fine discretization of the event stream),就不适用了~

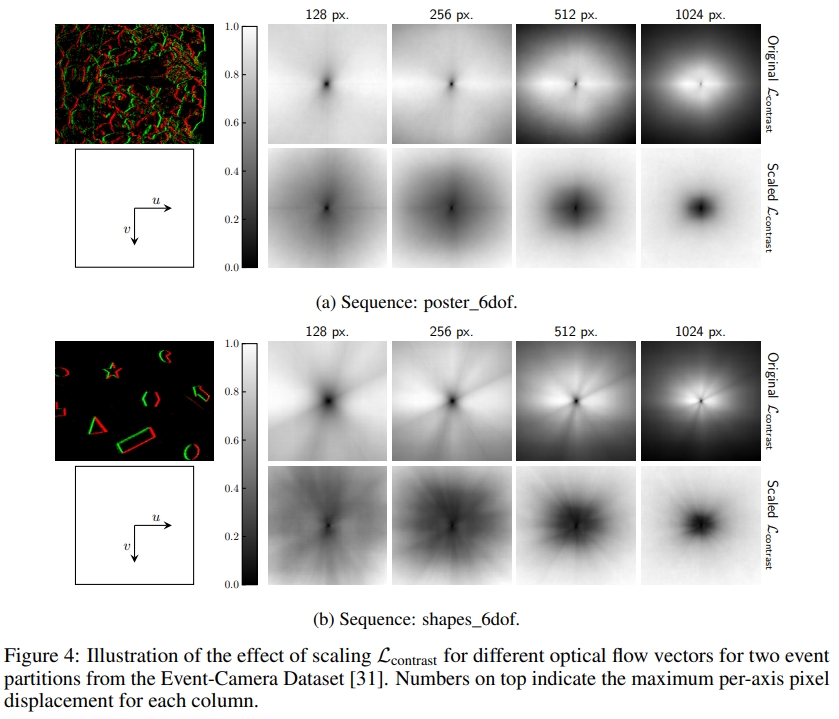

因此,作者对CM loss提出改进improves its convexity也就是额外除以pixel数:

如下图所示,确实通过添加了scaling factor,loss function显得更“凸”了~

此外作者也提到,CM算法是需要有足够的linear blur才是有效的,而此处采用SNN的结构,每次输入都是small number of event,因此作者提出相应的解决方案:

然而,基于CM的SSL还是存在两点局限性:

- the pipeline assumed that events move linearly within the timespan of their loss function. This assumption restricts the ability of the pipeline to accurately capture the true (and potentially nonlinear) trajectory of scene points over time.(也就是需要假设时间段内是线性运动的)

- the success of the self-supervised training heavily depended on the hyperparameters controlling the amount of motion information perceived by the networks before computing the loss.(也就是需要超参控制网络估算的运动信息幅度)

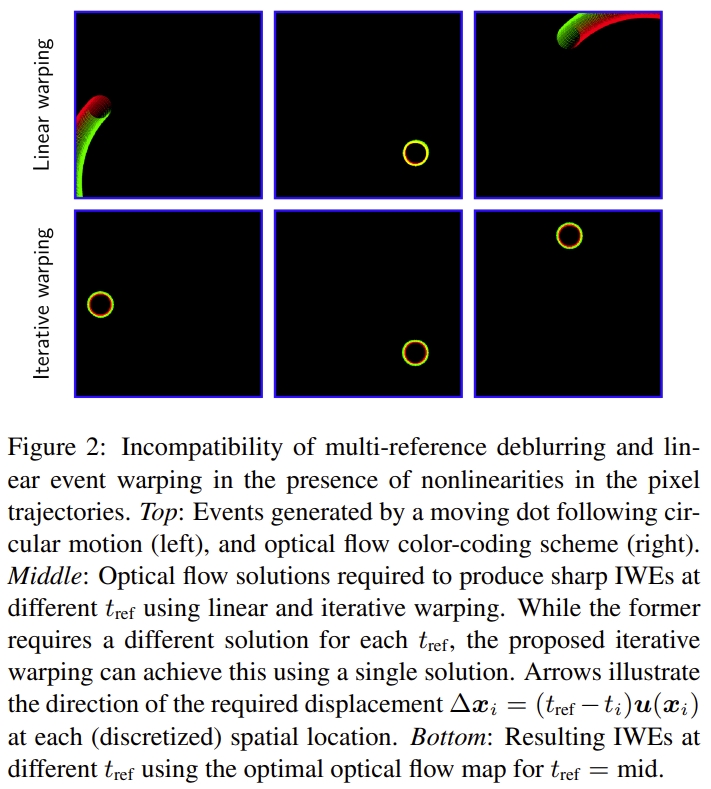

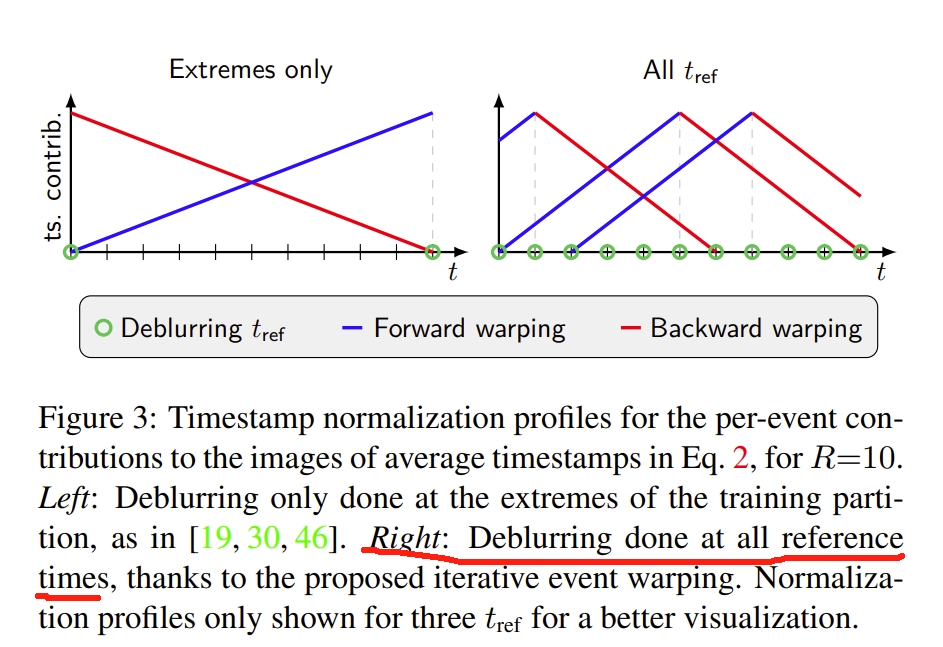

如下图(左下)所示。这些用CM来做self-supervised learning的方法都是需要假设events move linearly within the time window of the loss.因此在文献《Taming contrast maximization for learning sequential, low-latency, event-based optical flow (CVPR2023)》中,首先通过使用循环模型来处理小分区(small partitions)的事件流,而不是处理大量输入事件(也就是沿着他们上一篇论文《Self-supervised learning of event-based optical flow with spiking neural networks (NIPS2021)》来做)。这样可以很好利用event camera的high temporal resolution。这也就是论文中提到的sequential processing

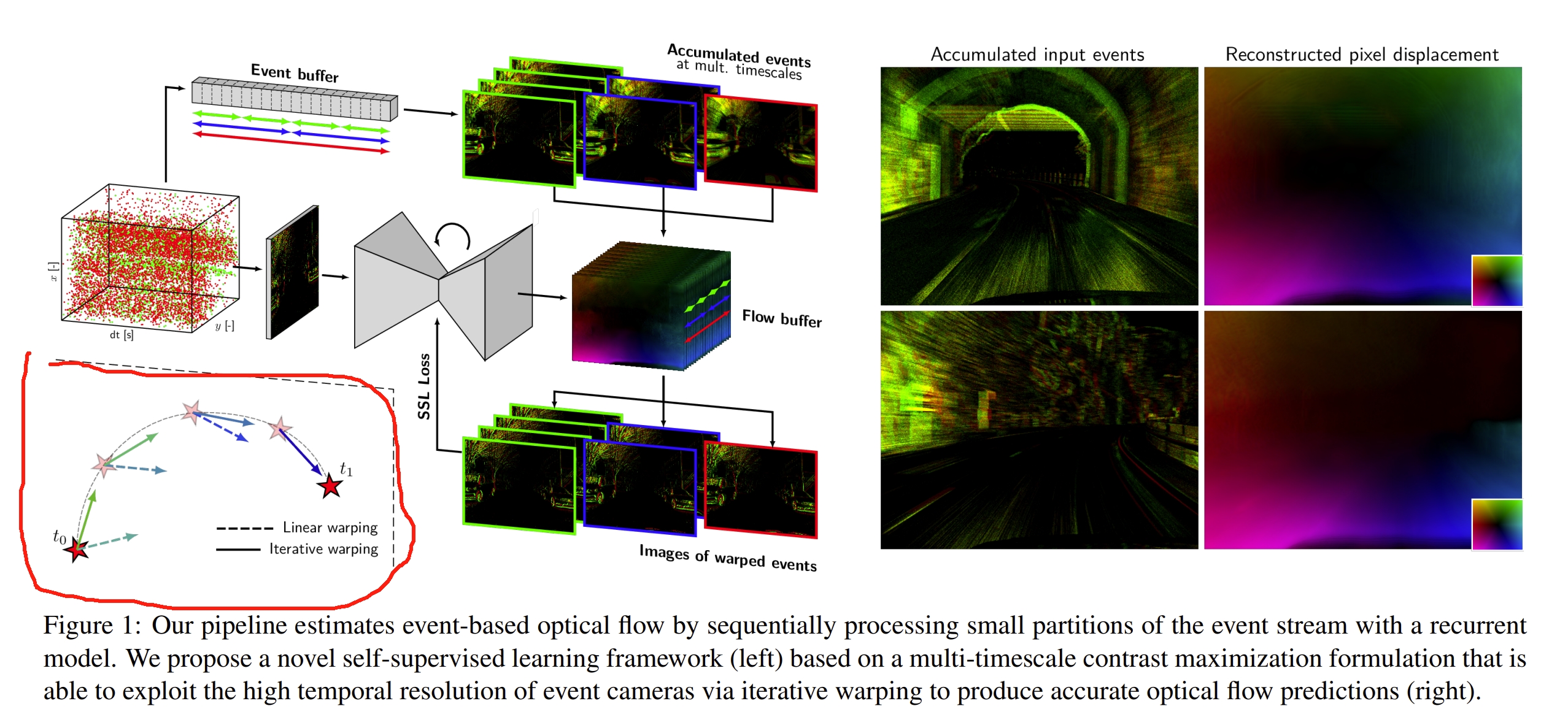

对于sequential processing作者通过实验验证了其有效性

同时再通过iterative event warping进而可以实现多段时间的event warp来避免假设事件是线性motion的~

|

|

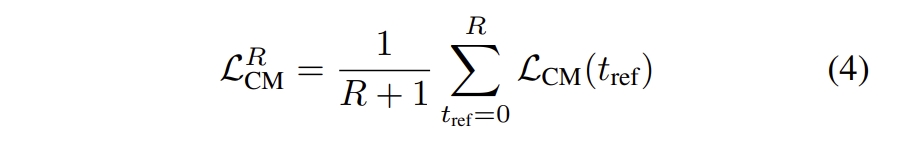

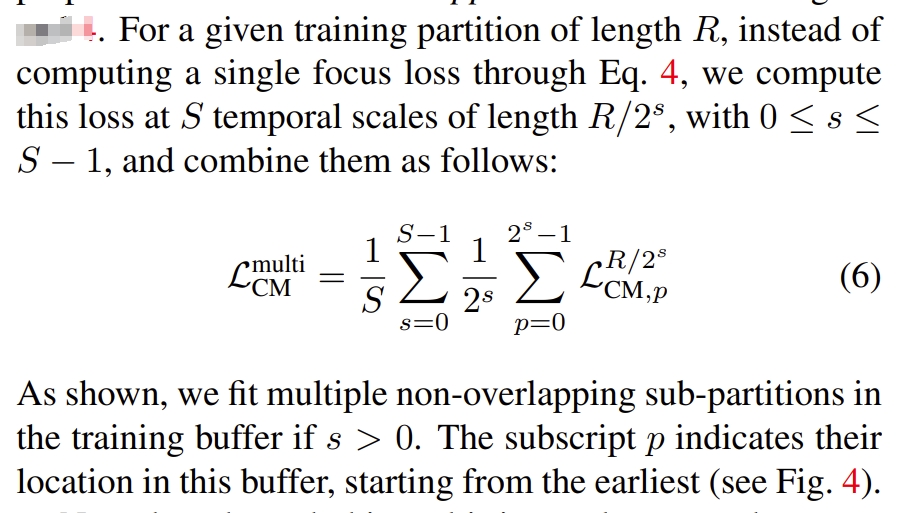

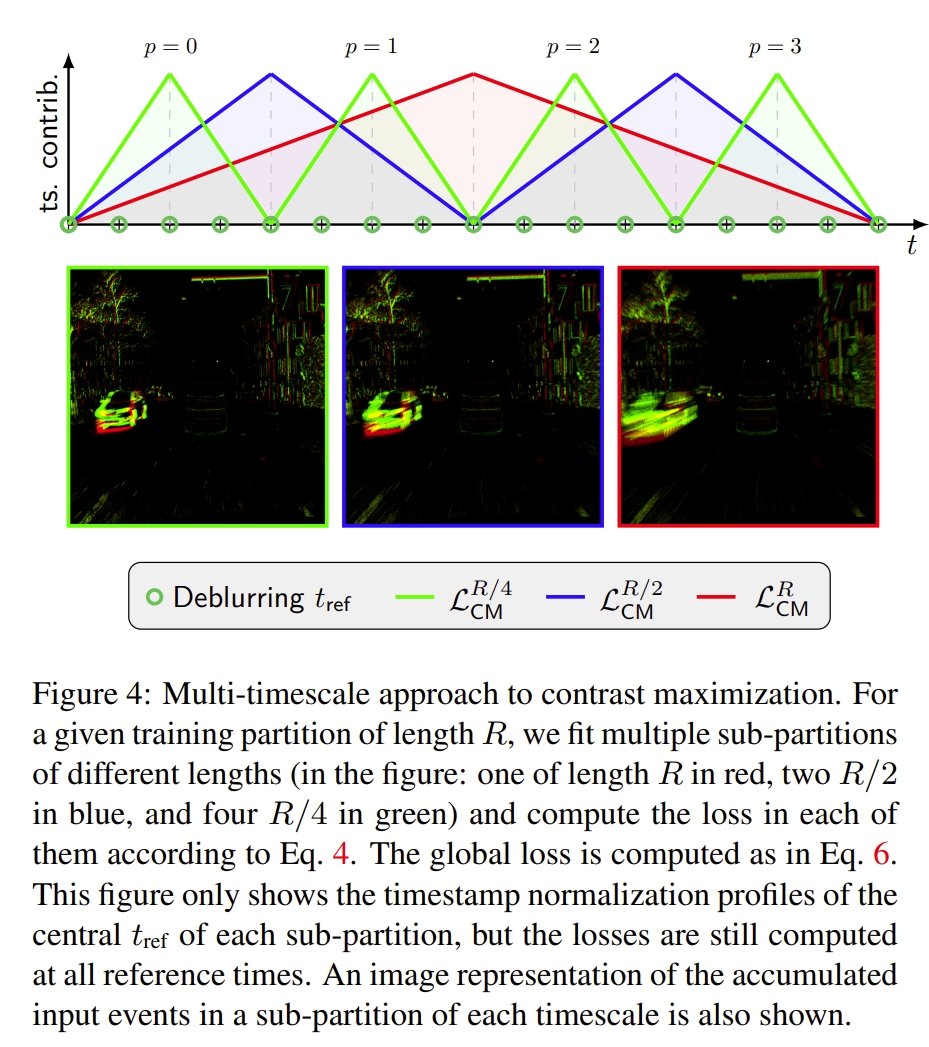

其次通过multiple temporal scales,也就是多种时间尺寸来累积事件,来处理CM framework。

|

|

而传统的其他CM方法则是如下:

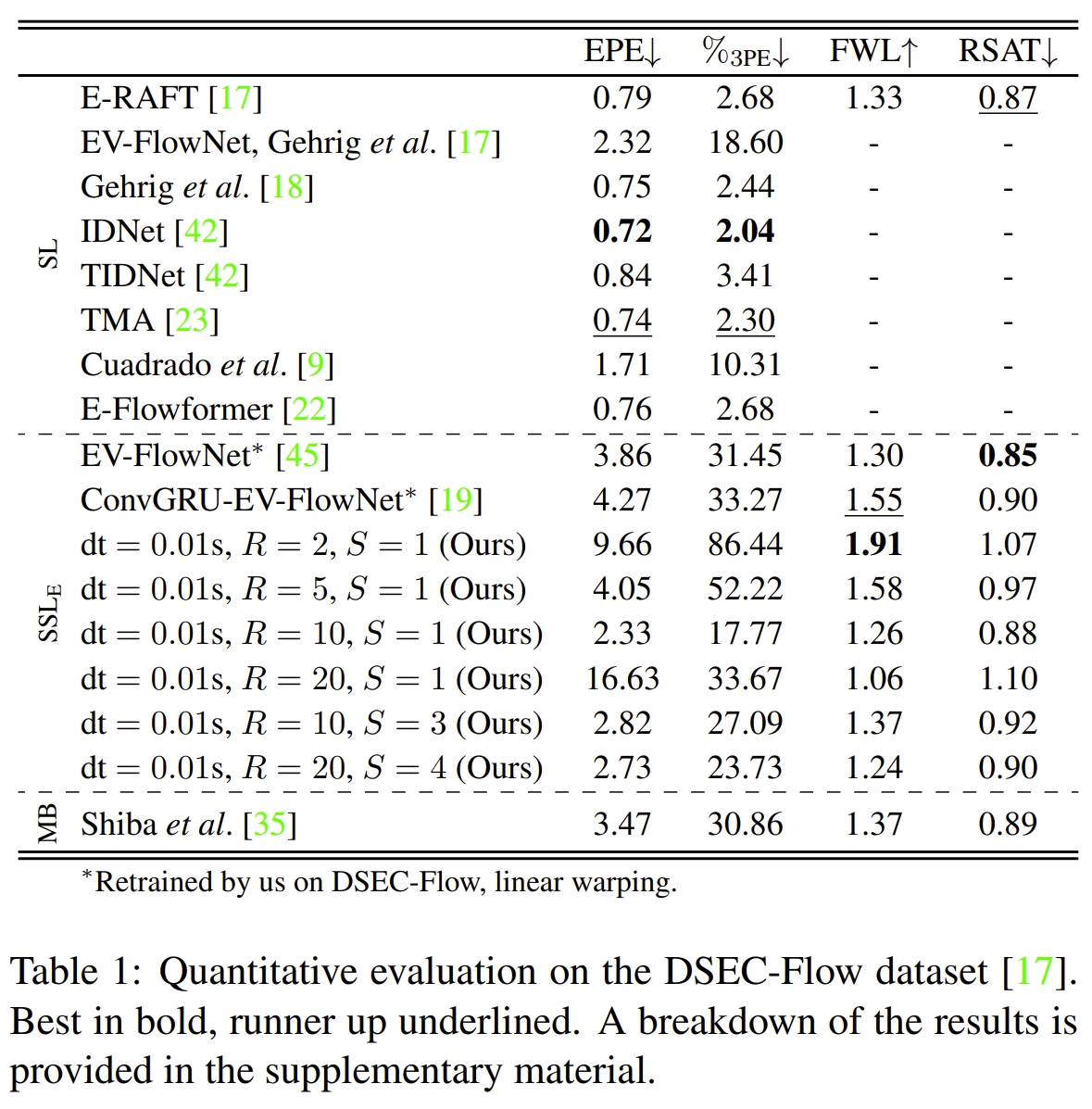

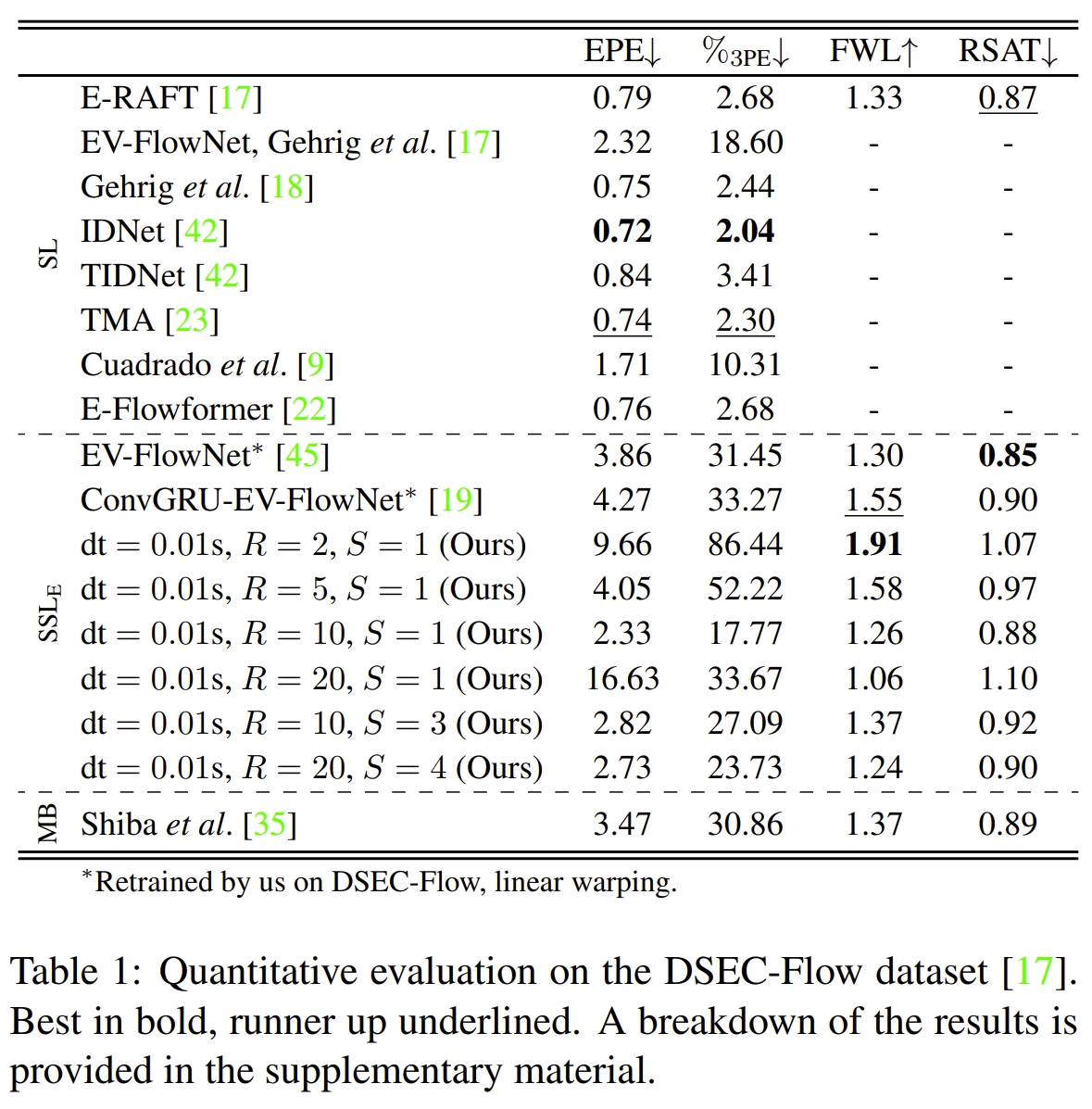

论文也通过大量的实验证明了这种multi-timescale CM framework超越所有基于CM的framework,仅仅不如用GT数据训练的纯supervised learning方法

|

|

Paper Resource

此处列出CMax相关或者用到CMax的文献。

- A Unifying Contrast Maximization Framework for Event Cameras, with Applications to Motion, Depth and Optical Flow Estimation (CVPR2018)

- Accurate angular velocity estimation with an event camera (RAL2017)

- Focus is all you need: Loss functions for event-based vision (CVPR2019)

- Event Cameras, Contrast Maximization and Reward Functions: An Analysis (CVPR2019)

- Unsupervised event-based learning of optical flow, depth, and egomotion (CVPR2019)

- Globally optimal contrast maximisation for event-based motion estimation (CVPR2020)

- Real-Time Rotational Motion Estimation With Contrast Maximization Over Globally Aligned Events (RAL2021)

- Globally-optimal event camera motion estimation (ECCV2020)

- Globally-optimal contrast maximisation for event cameras (TPAMI2021)

- paper

- 此篇是上一篇的期刊版本

- Self-supervised learning of event-based optical flow with spiking neural networks (NIPS2021)

- Unsupervised learning of a hierarchical spiking neural network for optical flow estimation: From events to global motion perception (TPAMI2019)

- Back to event basics: Self-supervised learning of image reconstruction for event cameras via photometric constancy (CVPR2021)

- Visual Odometry with an Event Camera Using Continuous Ray Warping and Volumetric Contrast Maximization (Sensor2022)

-

Contrast maximization-based feature tracking for visual odometry with an event camera (Processes2022)

-

Recursive Contrast Maximization for Event-Based High-Frequency Motion Estimation (IEEE Access2022)

- Event Collapse in Contrast Maximization Frameworks (Sensor 2022)

- A Fast Geometric Regularizer to Mitigate Event Collapse in the Contrast Maximization Framework (AIS2023)

- Taming contrast maximization for learning sequential, low-latency, event-based optical flow (CVPR2023)

- Density Invariant Contrast Maximization for Neuromorphic Earth Observations (CVPR2023)

- MC-VEO: A visual-event odometry with accurate 6-DoF motion compensation (TIV2023)

- CMax-SLAM: Event-based Rotational-Motion Bundle Adjustment and SLAM System using Contrast Maximization (TRO2024)

- Secrets of Event-based Optical Flow (ECCV2022)

- Secrets of Event-based Optical Flow, Depth and Ego-motion Estimation by Contrast Maximization (TPAMI2024)

- Motion-prior Contrast Maximization for Dense Continuous-Time Motion Estimation (ECCV2024)

- Secrets of Edge-Informed Contrast Maximization for Event-Based Vision

- EROAM: Event-based Camera Rotational Odometry and Mapping in Real-time

- Fully neuromorphic vision and control for autonomous drone flight (SRO2024)

- Event-Frame-Inertial Odometry Using Point and Line Features Based on Coarse-to-Fine Motion Compensation (RAL2025)

复现或测试CM相关工作

- CMax-SLAM: Event-based Rotational-Motion Bundle Adjustment and SLAM System using Contrast Maximization (TRO2024)的复现:CMax-SLAM-comment

- Taming contrast maximization for learning sequential, low-latency, event-based optical flow (CVPR2023)的复现:博客 and taming_event_flow_comment